2. Der Klimawandel und Folgen für die Energiewende

2.1 Klimaprognosen und-ziele

2.1.1 IPCC –Prognosen

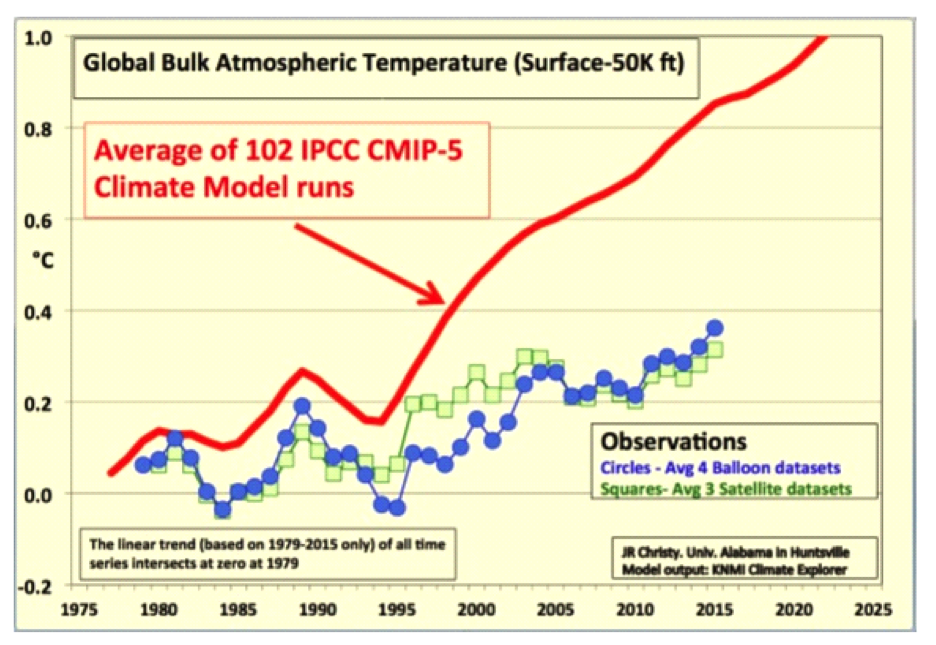

Mitte des 20. Jahrhunderts stellten Forscherinnen und Forscher vermehrt Anzeichen dafür fest, dass sich die Atmosphäre erwärmt und dass Aktivitäten des Menschen eine Ursache dafür sein könnten. Das Umweltprogramm der Vereinten Nationen (UNEP) und die Weltorganisation für Meteorologie (WMO) gründeten daraufhin 1988 den IPCC. Ziel war es zu klären, welche Gefährdung von der Erderwärmung ausgeht und ob gehandelt werden muss. (5)

So beschreibt die deutsche Koordinierungsstelle des IPCC (Intergovernmental Panel of Climate Change) seine Entstehung und Aufgaben.

Dazu veröffentlicht er seit 1990 alle sechs bis sieben Jahre Sachstandsberichte, die IPCC Assessment Reports.

Die zentralen Aussagen der fünf Sachstandsberichte 1990, 1995, 2001, 2007 und 2013/14. sind in (6) wiedergegeben.

Das Umweltbundesamt, basierend auf dem Bericht 2007 fasst die zu erwartenden Klimaänderungen und die empfohlenen Maßnahmen zusammen (7) und schreibt wie folgt:

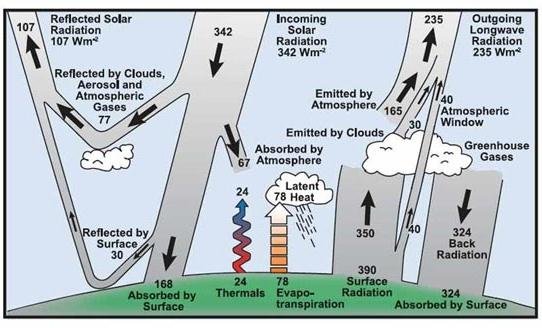

„Zur Untersuchung denkbarer Entwicklungen des Klimas in der Zukunft werden Klimamodelle genutzt. Damit führen die Fachleute Simulationen auf der Basis unterschiedlicher Emissionsszenarien durch. Die Ergebnisse derartiger Simulationen […] ermöglichen Aussagen über eine Bandbreite möglicher künftiger Klimaänderungen.

Globale Klimaänderungen bis 2100

Der anthropogene Treibhauseffekt verursacht Veränderungen im Klimasystem. Deren Ausmaße und Auswirkungen für die Zukunft können nur durch Modellrechnungen nachgebildet werden, da vielfältige und komplexe Wechselwirkungen berücksichtigt werden müssen. Aus Szenarienrechnungen lassen sich folgende mögliche zu erwartende Klimaänderungen für das 21. Jahrhundert ableiten (IPCC, 2007).

Bis zum Jahr 2100 wird von einem mittleren globalen Temperaturanstieg zwischen 1,8 (mit einer Schwankungsbreite von 1,1-2,9) und 4,0 (mit einer Schwankungsbreite von 2,4-6,4) Grad Celsius ausgegangen. […]

Werden die Treibhausgasemissionen nicht verringert, ist eine Erwärmung um 0,2 Grad Celsius pro Dekade für die nächsten 30 Jahre sehr wahrscheinlich. […]

Im Vergleich zum Zeitraum von 1980 bis 1999 wird bis zum Ende des 21. Jahrhunderts von einem Anstieg des Meeresspiegels für ein niedrigeres Szenario zwischen 18 und 59 Zentimetern und für ein höheres Szenario zwischen 26 und 59 Zentimetern ausgegangen (IPCC, 2007). […] Insgesamt sind die Aussagen über die zu erwartende Entwicklung des Meeresspiegels noch immer sehr unsicher.

Ganze Kontinente und Meeresbecken weisen deutliche Klimaänderungen auf. Modelle zeigen, dass sich diese Trends auch im 21. Jahrhundert fortsetzen.

- Arktis: Die durchschnittlichen Temperaturen stiegen in den vergangenen 100 Jahren doppelt so schnell wie im globalen Durchschnitt.

- Meereis: Satellitendaten zeigen seit 1978, dass die durchschnittliche jährliche Ausdehnung um 2,7 Prozent pro Jahrzehnt geschrumpft ist, im Sommer sogar um 7,4 Prozent.

- Niederschläge: Von 1900 bis 2005 wurden in vielen Regionen langfristige Veränderungen beobachtet. Zunahme der Niederschläge wie auch Austrocknung und Dürren.

- Meteorologische Extremereignisse: Die Häufigkeit von Starkniederschlägen hat zugenommen. Kalte Tage und Nächte sowie Frost sind seltener und heiße Tage und Nächte sowie Hitzewellen sind häufiger geworden. […]

Um eine gefährliche anthropogene Störung des Klimasystems zu verhindern, ist es erforderlich, die globale Temperaturerhöhung langfristig auf maximal zwei Grad Celsius über dem vorindustriellen Niveau zu begrenzen (8), wie beispielsweise der Wissenschaftliche Beirat der Bundesregierung Globale Umweltveränderungen (WBGU) in seinem Sondergutachten zeigt (WBGU, 2003). Wissenschaftliche Ergebnisse ( IPCC, 2004 ) weisen darauf hin, dass dieses Temperaturlimit mit hinlänglich großer Sicherheit nur unterschritten werden könnte, falls es gelänge, die Treibhausgaskonzentration bei 400 ppm CO2-Äquivalenten zu stabilisieren. Um eine derartige Stabilisierung zu erreichen, ist es erforderlich, dass die globalen Emissionen noch höchstens etwa bis zum Zeitraum 2015 bis 2020 steigen dürfen, um dann bis 2050 auf unter die Hälfte des Niveaus von 1990 zu sinken […]

Damit diese Lasten fair verteilt werden, ist es notwendig, dass die Industrieländer ihre Treibhausgasemissionen um 80 Prozent bis 2050 gegenüber 1990 mindern.“

2.1.2 Pariser Abkommen und die 2-Grad-Grenze

Im deutschen Wikipedia steht zum 2°C –Klimaziel

https://de.wikipedia.org/wiki/Zwei-Grad-Ziel

„Das Zwei-Grad-Ziel beschreibt das Ziel der internationalen Klimapolitik, die globale Erwärmung auf weniger als zwei Grad Celsius bis zum Jahr 2100 gegenüber dem Niveau vor Beginn der Industrialisierung zu begrenzen.

Das Ziel ist eine politische Festsetzung, die auf Grundlage wissenschaftlicher Erkenntnisse über die wahrscheinlichen Folgen der globalen Erwärmung erfolgte. […]

(Für den Beginn der Industrialisierung wird häufig das Jahr 1850 gesetzt, Genaueres unter (8).)

Der Wissenschaftlichen Beirat der Bundesregierung Globale Umweltveränderungen (WBGU) trug wesentlich dazu bei, dass die Zwei-Grad-Grenze in den politischen Prozess gelangte.“

In (9) wird die Plausibilitätsbetrachtung beschrieben, die die Festlegung des Klimaziels durch den WBGU erklärt. Dort steht u.a.:

“ So haben während mehrerer Jahrzehnte Intuitionen, Einwände und Einsichten dazu geführt, dass 2°C ein fokaler Punkt in der Klimadebatte geworden ist.“

Im Pariser Klimaschutzabkommen vom Dezember 2015 ist vereinbart den Anstieg der weltweiten Durchschnittstemperatur auf deutlich unter 2 °C gegenüber vorindustriellen Werten zu begrenzen, mit dem konkreten Ziel den Grenzwert 1,5 °C einzuhalten.

Der gegenüber 2° C niedere Grenzwert von 1.5° C wurde auf Initiative der kleinen Pazifik- Inselstaaten und einiger afrikanischer Länder in einem UNFCCC –Bericht im Mai 2015 vorgeschlagen. (https://unfccc.int/resource/docs/2015/sb/eng/inf01.pdf)

Auf die oben aufgeführten Prognosen des IPCC sowie auf Organisation und Arbeitsweise des Weltklimarats wird unter 2.6 noch näher eingegangen.

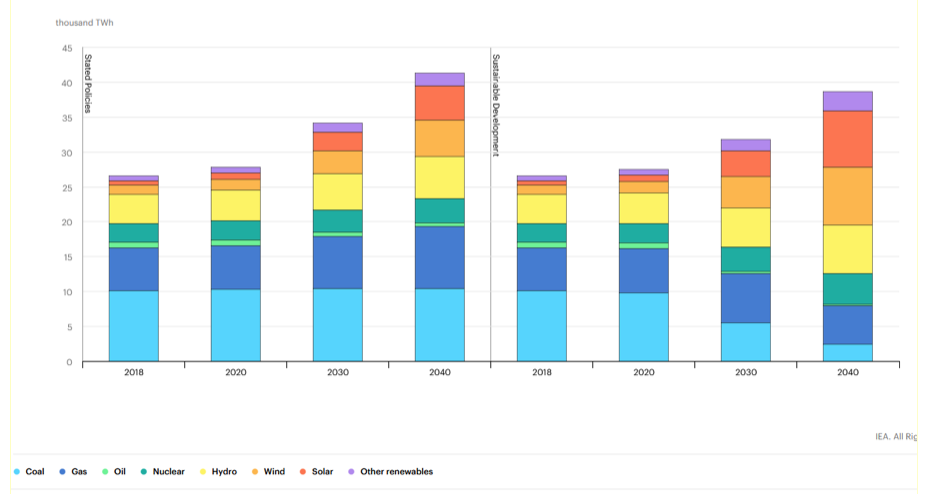

2.2 Die Energiewende: Energiebedarf, Kosten, Nutzen

2.2.1. Der totale Energiebedarf, erreichte Klimaziele 2018

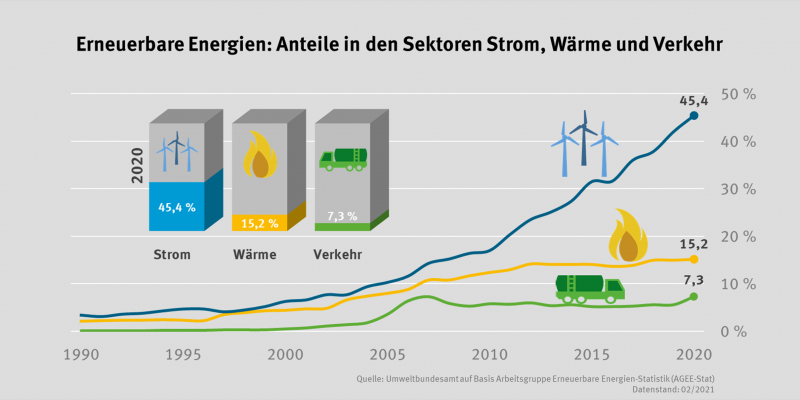

Im Jahre 2018 lag in Deutschland der Anteil der erneuerbaren Energien an der Stromerzeugung bei fast 38 Prozent und damit im Plan. Das Ziel, 2030 etwa 50 % zu erreichen erscheint überschaubar, aber zur Erreichung des Ziels von 80% in 2050 fehlen dann immer noch 30%. Bereits heute jedoch sorgen die bundesweit nahezu 30 000 Rotortürme für eine Belastung der Natur und der Bewohner, die sich in zunehmend schärferem Widerstand der Bevölkerung gegen neue Projekte niederschlägt (10).

Darüber hinaus stellt die Stromenergie nur etwa 1/5 des deutschen Energiebedarfs dar (Umweltbundesamt). Um vor allem auch den Energiebedarf für die Wärmeerzeugung und den Verkehr zu decken hat Deutschland demnach nach Erreichen der Ziele der Stromökologisierung immer noch 4/5 des Weges zur Dekarbonisierung vor sich (10). Dies macht einen Faktor von mehr als 10 um den die umweltfreundliche Energieerzeugung gegenüber heute (2018) erhöht werden muss.

Was den CO2 Ausstoß anlangt, stellt Umweltministerin Schulze 2018 fest, dass das für 2020 anvisierte Ziel von 40% Reduktion gegenüber 1990 mit voraussichtlich nur 32% nicht erreicht werden wird, begründet durch eine „unerwartet schnell wachsende Bevölkerung und Wirtschaft“ (11).

Die Union der deutschen Akademien schreibt in ihrer Stellungnahme „Sektorkopplung“ Optionen für die nächste Phase der Energiewende (2017) (12) :

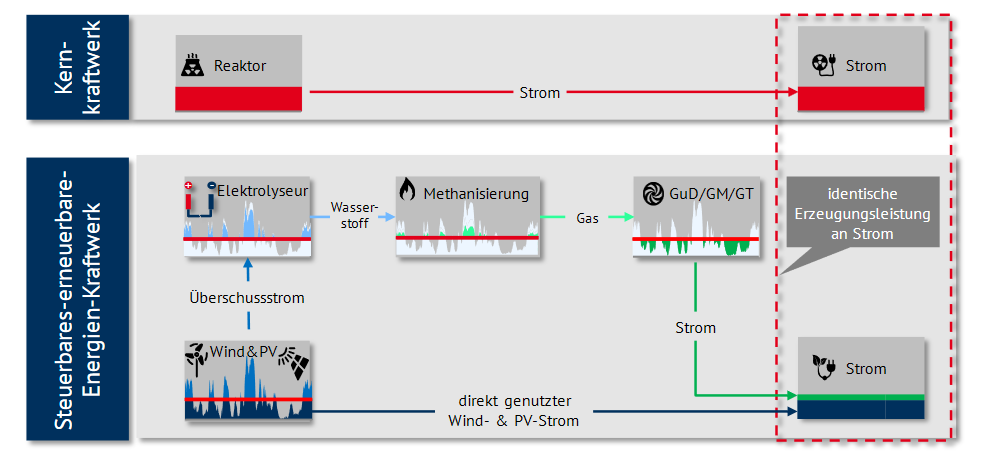

„Ein kontinuierlicher, deutlicher Ausbau erneuerbarer Energien zur Stromerzeugung führt nicht dazu, dass auf eine Bereitstellung einer Reserveleistung in ähnlicher Höhe wie die Leistung des heutigen konventionellen Kraftwerksparks verzichtet werden kann, da die Stromerzeugung aus erneuerbaren Energien selbst bei Installation erheblicher Mengen an Kurzzeitspeichern nur eine sehr geringe gesicherte Erzeugungsleistung aufweist.“

Die Energiewende wird schwerpunktmäßig im nationalen Kontext betrachtet. Das heißt, nur das deutsche Energiesystem wird im Detail analysiert und auf der Zeitschiene optimiert. Es gibt jedoch theoretisch eine Option, mit der man eine umfassende europäische Energiewende im Stromsektor realisieren könnte, das europäische Supergrid. Es besteht aus sehr leistungsfähigen Übertragungsnetzen, die einen Austausch großer elektrischer Energiemengen mit Hilfe der Hochspannungs-Gleichstromübertragung (HGÜ-Technik) ermöglichen (13). Die Genehmigungsverfahren zum Bau dieser Stromautobahnen sowie die Einigung mit den Stromerzeugern aus Kohle-, Gas,-und Atomkraftwerken der europäischen Partnerländer werden jedoch mühsam und langwierig sein, d.h. die Abschaltung unrentabler Kraftwerke mit Energien durch Verbrennung fossiler Materialien (Kohle, Gas) wird möglicherweise nicht in dem zur Zeit geplanten Maße weitergehen (4) und auch bei den Protagonisten der erneuerbaren Energien setzt sich die Überzeugung durch, dass noch längere Zeit konventionelle Kraftwerke, vorzugsweise Gaskraftwerke beibehalten werden müssen.

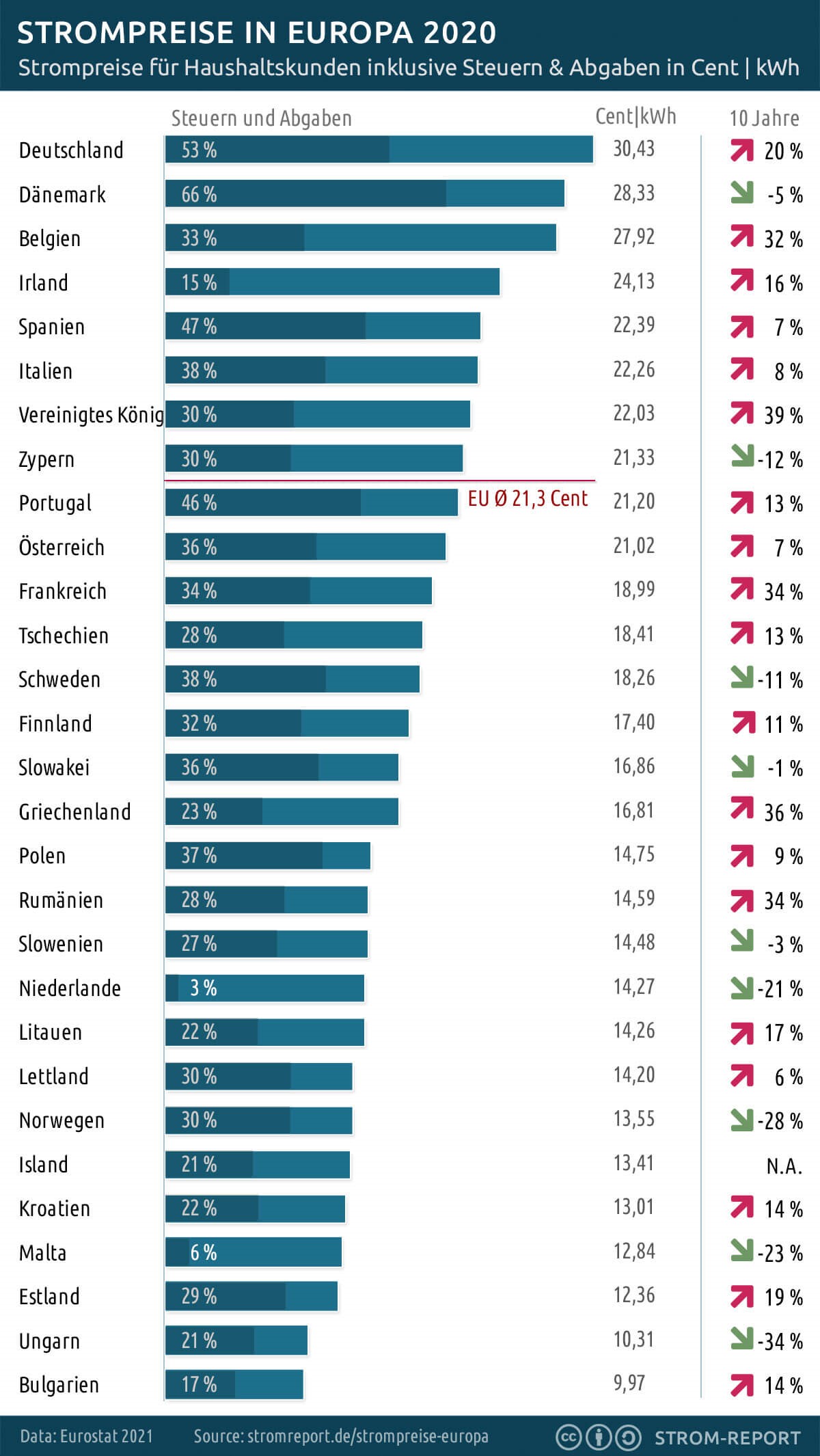

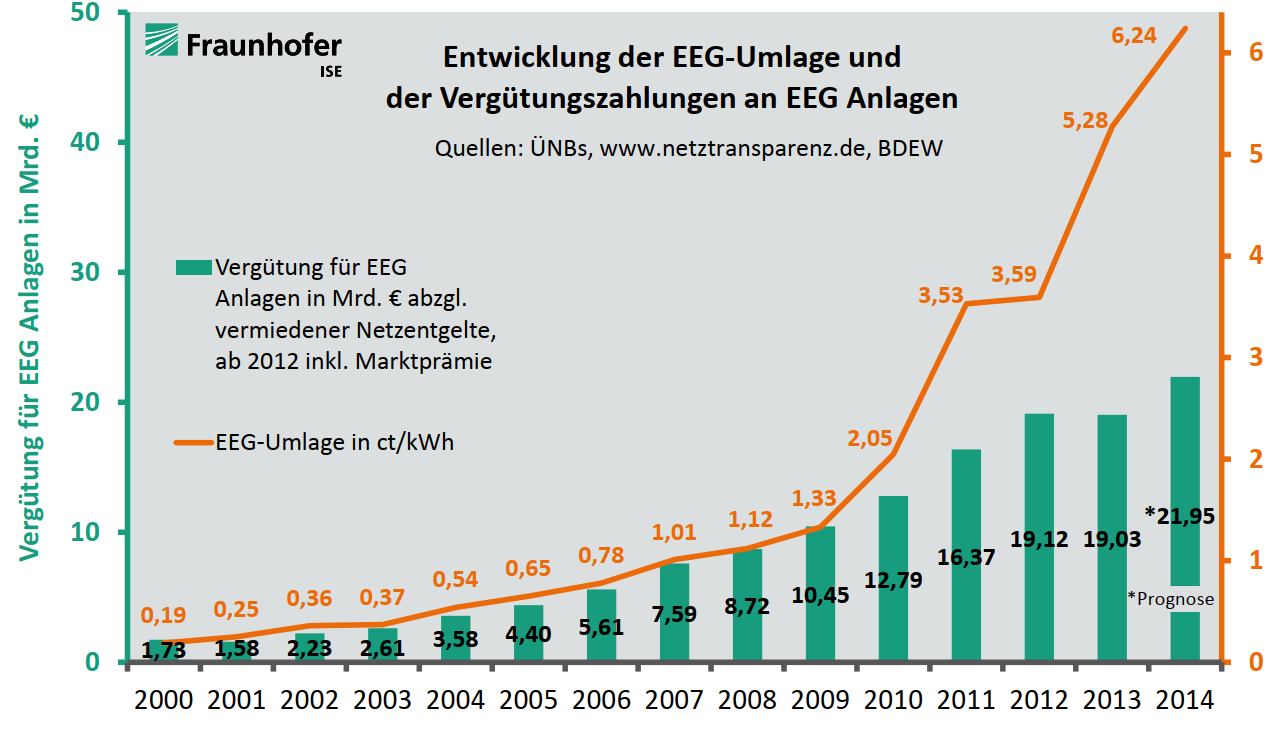

2.2.2 Kosten der Stromökologisierung

Das Institut für Wettbewerbsökonomie an der Uni Düsseldorf (DICE Consult) hat in einem Gutachten die Kosten der Energiewende nur für den Strombereich berechnet (15).

• Das Ergebnis: Im Zeitraum zwischen den Jahren 2000 bis 2025 müssen geschätzt rund 520 Milliarden Euro aufgewendet werden.

• Eine vierköpfige Familie zahlt somit bis 2025 direkt und indirekt über 25.000 Euro für die Energiewende.

Soweit die voraussichtlichen Kosten zur Stromökologierung.

2.2.3 Sektorkopplung und Gesamtkosten

In (12) veröffentlichen die Deutsche Akademie der Technikwissenschaften , die Deutsche Akademie der Naturforscher Leopoldina sowie die Union der deutschen Akademien der Wissenschaften , eine Studie unter dem Titel „Sektorkopplung: Untersuchungen und Überlegungen zur Entwicklung eines integrierten Energiesystems“. Die Studie berechnet die Kosten für verschiedene Szenarien einer weitgehenden Dekarbonisierung bis 2050 bei einer heutigen CO2 Emission in Deutschland von rund 900 Mio t .

Diese vom Bundesministerium für Bildung und Forschung finanzierte Studie betrachtet die Kosten der Ökologisierung ganzheitlich für alle Sektoren des Energiesystems, nämlich Strom, Verkehr und Wärme. Sie kommt zum Ergebnis, dass zukünftig nur eine alle Sektoren übergreifende Herangehensweise eine Perspektive dafür bietet, die Energieversorgung insgesamt schrittweise auf überwiegend erneuerbare Energien umzustellen.

Rechnungen mit Hilfe eines Optimierungsmodells beschreiben technisch mögliche Entwicklungspfade für unterschiedliche Szenarien des Energiesystems. Die Optimierung zielt auf eine Minimierung der Kosten unter Berücksichtigung spezieller Randbedingungen ab.

Szenarien des Energiesystems

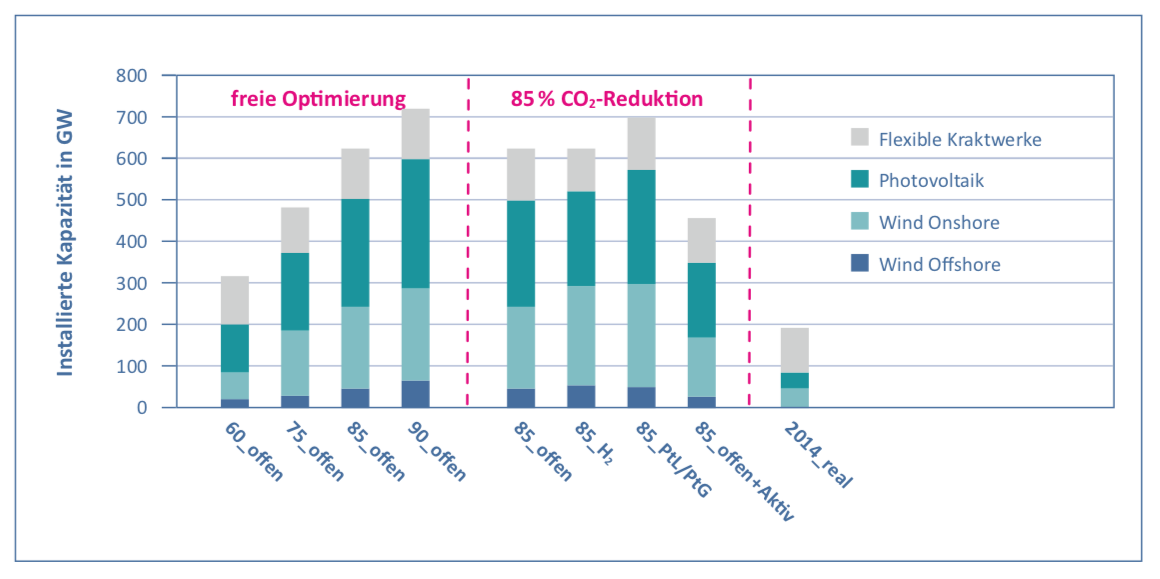

Die untersuchten Szenarien unterscheiden sich einmal durch die auf der Horizontalen der untenstehenden Abb. angegebenen CO2- Reduktionen von 60%, 75%, 85% und 90%. Bei der freien Optimierung („offen“) wird die Technologiezusammensetzung von „Wind Offshore“, „Wind Onshore“, „Photovoltaik“ und flexiblen Kraftwerken durch die Kostenminimierung bestimmt.

Bei einigen -85% Szenarien sind zusätzliche Randbedingungen festgelegt, zum einen ein Energiesystem bei der Wasserstoff H2 eine besonders große Rolle spielt , zum anderen eine Entwicklung mit starkem Einsatz von regenerativ erzeugten Kraftstoffen für Verkehr und Wärme (Methan, flüssige Kraftstoffe) . Als flexible Kraftwerke kommen grundsätzlich sämtliche Techniken, die lagerbare chemische Energieträger verwenden in Betracht, von Blockheizkraftwerken in Gebäuden oder Wärmenetzen über Gasturbinen und Brennstoffzellen bis hin zu großen Gas- und Dampfkombikraftwerken. Als Brennstoff kommen fossile Energieträger, Biomasse oder synthetische Gase (Wasserstoff oder Methan), die aus Strom hergestellt und in Speichern gelagert werden, infrage

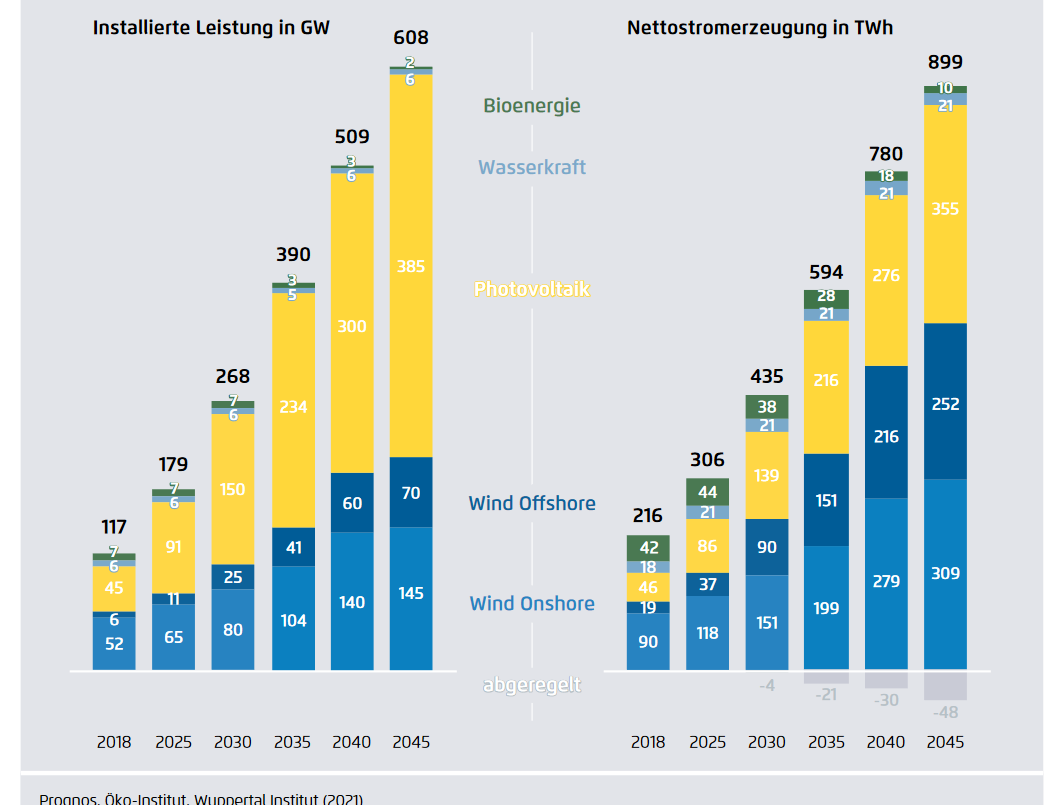

Bild1: Installierte Leistung an umweltfreundlichen Energien im Stromsektor 2050

Erwartungsgemäß steigt die installierte Leistung für erneuerbare Energien mit dem CO2 Reduktionsziel an. Während heute die installierte Leistung im Stromsektor bei weniger als 100 GW liegt (2018, Statista), erreicht sie 2050 bei den -85% -Szenarien Werte bis 500 GW.

Dabei ist der Anteil der Windkraft bei etwa 250 GW, was etwa das 4-fache der heutigen Leistung ist (2018 etwa 60 GW)). Bemerkenswert der Anstieg der Photovoltaik-Energie von heute (2018) 45 GW auf 250 GW , also mehr als das 5-fache.(Effizienzszenario s.u. unter Windkraftanlagen)

Reservekapazität: Die wegen des fluktuierenden Charakters von WK und PV benötigte Reservekapazität beträgt zwischen 60 und 100 Gigawatt. Heute sind etwa 100 Gigawatt an konventionellen Kraftwerken installiert. Das bedeutet, dass die benötigte Reservekapazität nicht abnimmt. Erdgas dürfte auch langfristig als flexibler, emissionsarmer Energieträger eine Rolle spielen

Speicher: Neben Erneuerbare-Energie-Anlagen und Reservekraftwerken sind zunehmend Speicherkapazitäten erforderlich. Als Kurzzeitspeicher für Strom (für Stunden bis Tage) können vor allem Pumpspeicherkraftwerke und Batterien eingesetzt werden. Für die Langzeitspeicherung sollten mit Strom gut speicherbare Brenn- und Kraftstoffe wie Wasserstoff oder Methan erzeugt werden.

Gesamtkosten der Dekarbonisierung

Bild 2: Kumulative systemische Gesamtkosten bis zum Jahr 2050

für die verglichenen Systementwicklungen und ihre Zusammensetzung

Anhand der obigen Abbildung wird deutlich, dass sich die Kosten für die Entwicklung des Energiesystems als Ganzes mit steigenden Reduktionszielen, bei sonst gleichen Randbedingungen, stark erhöhen. Eine Steigerung der Reduktion von -80 % auf -90% entspricht etwa einem Mehrkostenbetrag von etwa 1000 Milliarden €.

Die Kosten für das Referenzszenario belaufen sich auf etwa 4000 Milliarden €. Beim Referenzszenario werden bis 2030 die energiebedingten CO2-Emissionen um 40% verringert und bleiben in der Folgezeit konstant.

Die Emissionsminderung auf 85% kostet über 6000 Milliarden bei freier Kostenoptimierung und etwa 4500 Milliarden für das Einsparungs-und Effizienzsteigerungsszenario.

Nach dem Szenario der freien Kostenminimierung fallen zum Erreichen des Klimaschutzziels von -85 Prozent bis zum Jahr 2050 insgesamt Mehrkosten (in Bezug auf die Referenz) in Höhe von rund 2 Billionen Euro an, Dieser Wert entspricht im Mittel der nächsten 33 Jahre einem jährlichen Betrag von etwa 60 Milliarden Euro und somit knapp 2 Prozent des deutschen Bruttoinlandsprodukts von 2016.

Eine Studie des Frauenhofer -Instituts für solare Energiesysteme (ESYS) (14) ergibt als kumulative Kosten 2015-2050 für verschiedene -80% CO2-Szenarien Kosten zwischen 5300 und 5800 Milliarden € und 4200 Milliarden € für das Referenzszenario (Fortschreibung der heutigen Systemzusammensetzung). Für ein -90% Szenario fallen Gesamtkosten von etwa 6500 Milliarden € an.

2.2.4 Der globale Nutzen der deutschen Dekarbonisierung

Der globale CO2-Emissionsanteil Deutschlands beträgt etwa 2,3 % in 2016, dagegen sind die 3 größten Kohlendioxid-Produzenten der Welt China, Indien und die USA für etwa 50% verantwortlich, bei einem jährliche Zuwachs von etwa 3% . Würde es Deutschland also gelingen seinen gesamten Ausstoß auf Null zurückzufahren, dann würde allein der jährliche Mehrausstoß dieser 3 größten CO2-Emittenten in etwas mehr als einem Jahr die deutschen Anstrengungen zunichtemachen.

Eine Abschätzung ergibt, dass wenn der deutsche CO2-Ausstoß auf Null gesetzt würde, die Auswirkung auf die globale Temperatur maximal nur etwa 0,01 Grad (20)(20a) betragen würde und somit in der Praxis nicht bemerkbar wäre .

Und der „Energiehunger“ wird rasant weiter steigen. In einer SPIEGELONLINE – Meldung vom 13. November 2007 heißt es:

„… Alle Welt redet vom Klimawandel, der CO2-Vermeidung und dem Energiesparen. Eine gestern in Rom vorgestellte Studie des Weltenergierates WEC zeigt, wie schwer der Kampf gegen die Erderwärmung noch werden dürfte. Denn der Energiebedarf der Menschheit steigt und steigt – und könnte sich bis 2050 verdoppeln. Der WEC-Prognose zufolge wird sich die globale Nachfrage nach Strom, Öl, Gas und Kohle um 70 bis 100 Prozent erhöhen.“

2.3 Erneuerbare Energien: Effizienz, Schäden an Natur und Gesundheit

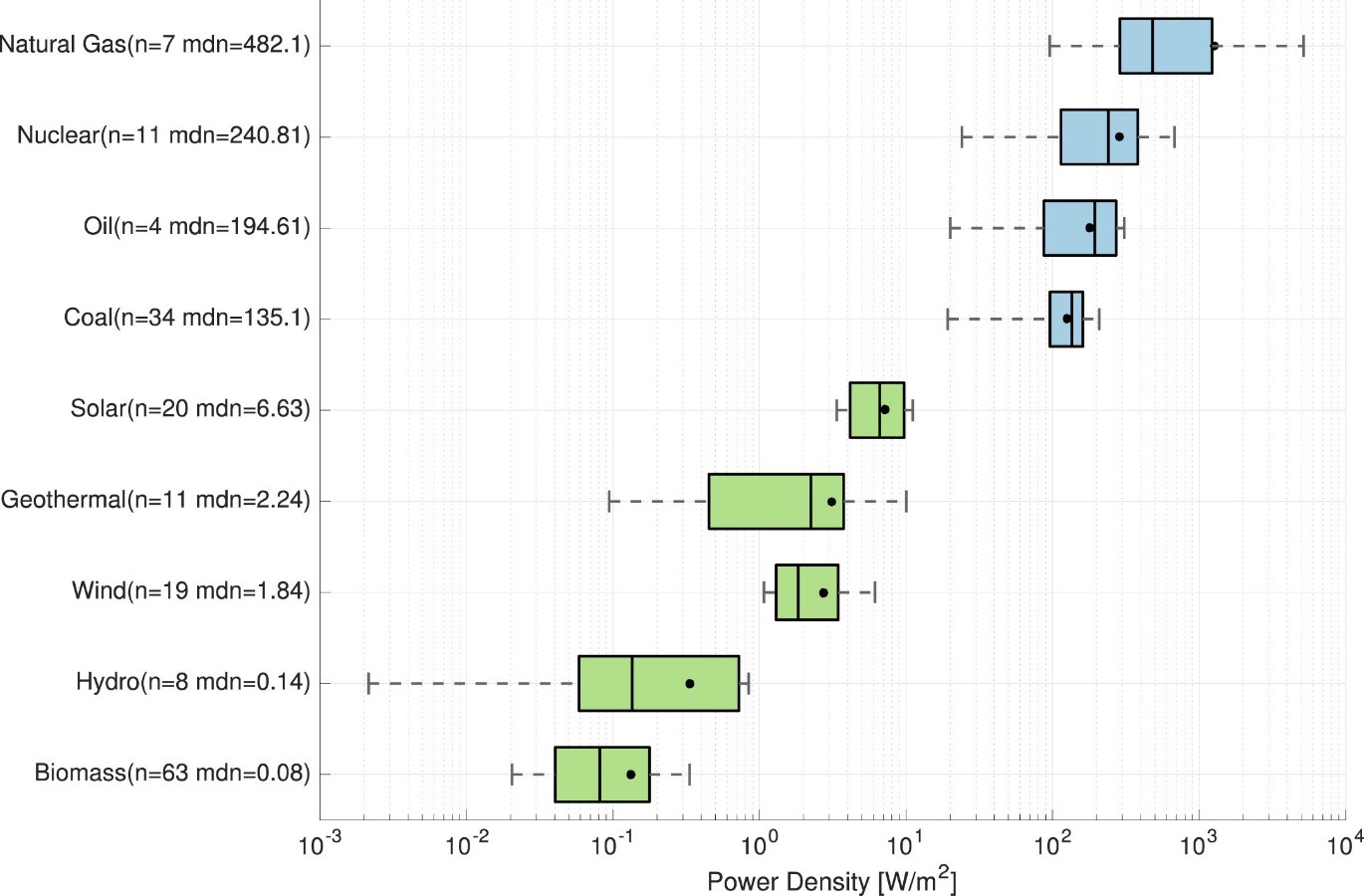

In den Kapiteln 2.2.2 und 2.2.3 wurden die Kosten der Energiewende im Bereich von 4-6 Billionen Euros abgeschätzt. Der folgende Abschnitt dient dazu die Gründe für diese immensen Kosten deutlich zu machen. Es werden kurz die physikalischen Größen „Leistungsdichte“ und „Energiedichte“ diskutiert. Sie liefern die technische Erklärung für die gewaltigen Kosten der geplanten Strukturveränderungen und der notwendigen Investitionen, wie sie für die Windkraft, die Photovoltaik und die Elektromobilität erforderlich sind: Windräder mit einer Höhe von mehr als 150 m, Rodungen von großen Waldflächen, große Flächen auf Dächern und in Naturlandschaften für Photovoltaik-Elemente, ausgedehnte engmaschige Stromnetze oberhalb und unterhalb des Erdoberfläche für die Ladeinfrastruktur von Elektroautos, Gelder für Forschung und Entwicklung der Speichertechnologien, neu zu entwickelnde großtechnische Industrieverfahren für die Entsorgung und das Recycling der Rotorblätter, Solarmodule und Batterien.

Leistungsdichte und Kosten Infrastruktur,

Nach (21b) ist die Leistungsdichte S durch

S= P/A

definiert.

„P ist die Leistung in Watt, A die Fläche in m², d.h. S wird in der Einheit Watt /m² gemessen. Bei der Windturbine ist mit S die Leistung des Windes, geteilt durch die vom Propeller überstrichene Fläche bei senkrecht auftreffendem Wind gemeint. Bei der Photozelle ist es die Leistung der Sonne, geteilt durch die Solarzellenfläche bei senkrechtem Sonneneinfall. […]

Die Bedeutung einer hohen Leistungsdichte S wird aus A×S=P deutlich. Ist S klein, muss man die Fläche groß machen, damit das gewünschte Endprodukt P ausreichend hoch ausfällt. Dies erklärt warum Windradpropeller so riesig sind. Weil Wind nur eine extrem kleine Leistungsdichte aufweist ( Autor: nach Kapitel 6.1 von (21b) ist S der sehr geringen Luftdichte proportional), ist eine -ebenso extrem- große, vom Propeller überstrichene Fläche bereitzustellen. […]

Bei der Fotozelle ist die Platte groß genug zu machen ( Autor: da auch hier die Leistungsdichte nur gering ist, wegen der geringen Leistungsdichte der auf die Erdoberfläche fallenden Sonnenstrahlung, siehe nachfolgende Tabelle). . „High-Tech“ wird oft auch über die Leistungsdichte definiert. In diesem Sinne sind Wind- und Solarkraftwerke eindeutig „Low-Tech“. […]

„ Ein Kohlekraftwerk hat eine 2000-fache höhere Stromleistungsdichte als ein WKA-Ungetüm (Autor: Windkraftanlage) in der windstarken Nordsee und sogar eine 25 000-fach höhere als die Solarplatten auf dem Hausdach Ihres Nachbarn (siehe Tabelle).

Aus den Vergleichen wird anschaulich, dass Wind und Sonne grundsätzlich extrem teurer sind als Kohle und Uran, denn wir können die Leistungsdichte von Wind und Sonne mit keiner Maßnahme erhöhen. […].

Der minimale Energieertrag und, als Folge davon, die extrem hohen Kosten der Photovoltaik sind mit der Begeisterung der Bevölkerung für diese Methode nicht vereinbar.“

2.3.1 Windkraftanlagen: Kapazität in Deutschland, Ausbaupläne

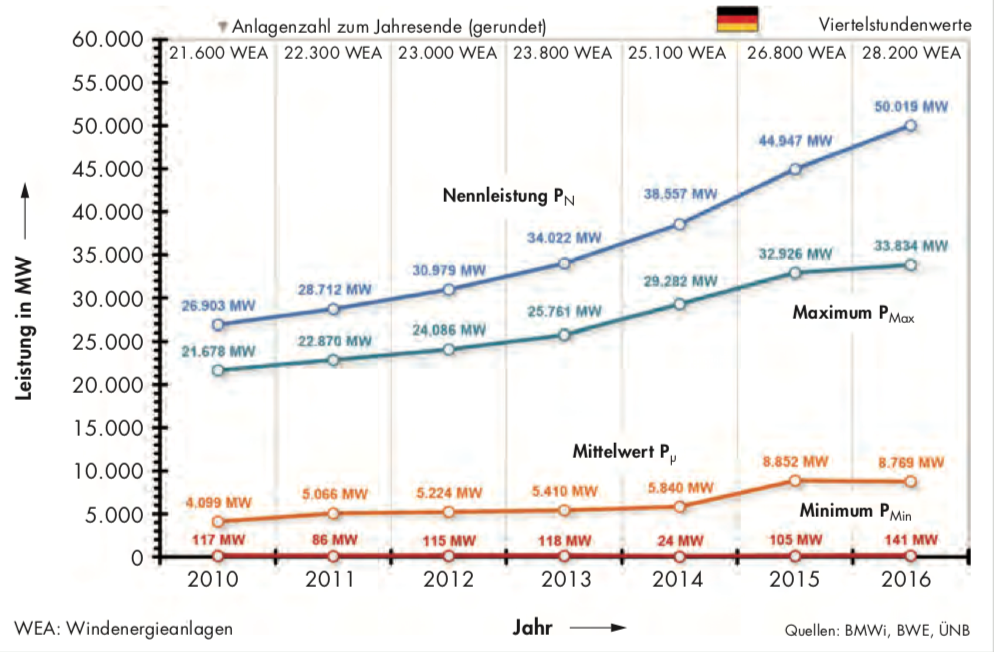

Bild : Windenergienutzung in Deutschland 2010-2016

In einer Studie über die Windkraft in Deutschland schreibt die die VGB Powertech (16)

„In der Abb sind relevante Kennzahlen für die Entwicklung der Windenergie in Deutschland im Zeitraum von 2010 bis 2016 dargestellt. Demnach hat sich die kumulierte installierte Nennleistung des deutschen Windparks von 26.903 MW am Jahresende 2010 bis zum Jahresende 2016 fast verdoppelt. Die Anzahl der Windenergieanlagen, jeweils zum Jahresende und gerundet, erhöhte sich zeitgleich von 21.600 auf 28.200 Aggregate.

Die durchschnittliche Nennleistung jeder neu zugebauten Onshore-Windenergieanlage lag im Jahr 2010 bei 2,0 MW. Bis zum Jahr 2016 erhöhte sich dieser Durchschnittswert auf 2,8MW (Offshore-Windenergie: 5,2MW pro Anlage). […]

Der arithmetische Mittelwert ist ein Maß für die jährlich bereitgestellte Energie und spiegelt die konstante Leistung wider, die ein Kraftwerk für diese Energie bei konstanter Fahrweise über ein Jahr erbringen müsste. […]

Das resultierende Verhältnis aus mittlerer Leistung zu potenzieller Leistung (Nennleistung) wird auch als Ausnutzung bezeichnet. Die Ausnutzung ist dimensionslos und als Maß für die Anzahl der Jahresstunden zu verstehen, in denen der Windpark umgerechnet seine Nennleistung erbrachte. Multipliziert mit der Anzahl der Jahresstunden ergeben sich die Volllaststunden des Windparks im betreffenden Jahr. […]

Von 2010 bis 2016 erreichte die Ausnutzung einen Durchschnittswert von rund 18%. […].

Hinsichtlich des Beitrags der Windenergie zur Versorgungssicherheit gibt insbesondere die Entwicklung der jährlichen Minima der Leistungszeitreihen gemäß Bild 3b Aufschluss: Diese Werte liegen seit 2010 erstaunlicherweise auf unverändert niedrigem Niveau von durchschnittlich 100MW, obwohl sich die Nennleistung des deutschen Windparks zeitgleich fast verdoppelt hat. [,,,]

Offenbar hat sich die intuitive Erwartung, dass der Minimalwert bei einem Ausbau deutschlandweit verteilter Windenergieanlagenstandorte nach dem Motto „irgendwo weht immer Wind“ ansteigt und der Ausbau der Windenergienutzung in zunehmendem Maße eine Substitution konventioneller Kraftwerksleistung ermöglicht, nicht erfüllt. […]

Die permanent verfügbare (gesicherte) Leistung des deutschen Windparks lag damit immer deutlich unter einem Prozent seiner Nennleistung oder anders ausgedrückt: Im jedem Jahr gab es immer mindestens eine Viertelstunde, in der mehr als 99 % der Nennleistung des deutschen Windparks nicht verfügbar waren und praktisch ein Bedarf an 100% planbarer Backup-Leistung herrschte.[…]

Aus Sicht der Versorgungssicherheit hat die Windenergie in Deutschland damit bisher (bis 2016)konventionelle Kraftwerksleistung von maximal 150MW ersetzt. Zum Vergleich: Für die Stabilität des Stromnetzes wird hierzulande zum Zeitpunkt der Jahreshöchstlast, die meist spätnachmittags an einem Tag im Zeitraum von November bis Februar auftreten kann und vorab unbekannt ist, eine Kraftwerkskapazität von etwa 77.000 bis 82.000MW benötigt.“

ESYS (12) stellt fest, dass ein starker Zubau an Anlagen zur Stromerzeugung aus Sonne und Wind unabdingbar ist. Sowohl gesellschaftliche Akzeptanzgründe als auch Aspekte der Flächennutzung und des Naturschutzes legen jedoch Systementwicklungen nahe, die diesen Ausbau so gering wie möglich halten

Um also die zu installierende Leistung zu begrenzen wurde in der ESYS Studie in einem weiteren Szenario (85_offen+Aktiv) für 2050 eine durch Einspar-und Effizienzmassnahmen erzielte Stromnachfrage von -25% gegenüber heute angenommen. Damit reduziert sich der Beitrag von Windkraft und Photovoltaik, etwa im Verhältnis 50/50, auf 350 GW.

Nach der Studie des Frauenhoferinstituts (14)

beläuft sich die in 2050 installierte Leistung für die Windkraft auf Werte zwischen 190 und 220 GW (für die verschiedenen Szenarien) und 170 und 200 GW für die Fotovoltaik.

Gegenüber der heutigen Situation entspricht dies einer Vergrösserung der installierten Windkraft um das Dreifache und um das 4fache für die Photovoltaik..

Detlef Ahlborn (17) schätzt eine benötigte Installation von etwa 60 000 Windkraftanlagen ab, also gegenüber heute eine Verdopplung der bereits installierten Anlagen.

Wiesenvogelbrutgebiet Weenermoor, LK Leer. Quelle: https://www.wattenrat.de/

Die Windbranche versucht durch Windräder mit höherer Nennleistung die Zahl der benötigten Neuinstallationen zu reduzieren (18). Die neuesten Entwicklungen „Windkraft 4,0“ haben eine Rotordurchmesser von 170 m bei einer Nennleistung von 5,6 Megawatt. (Entwickler Vensys, Mutterkontern Goldwind , China)

Im deutschen Baugesetzbuch der wird ein Mindestabstand von 1000m zur Wohnbebauung festgeschrieben, es ist aber den Bundesländern überlassen diesen Abstand zu verringern. Um den Widerstand der Anwohner zu verringern sollen Anwohner und Kommunen mit „Windbürgergeld“ und finanzielle Windkraftbeteiligungen entschädigt werden (18a) .

Manfred Knake , Vertreter von „Wattenrat“, einem lockeren Zusammenschluss von Naturschützern aus der Küstenregion Ostfrieslands, bezeichnet das Windbürgergeld als fragwürdiges Schweigegeld. Es geht den Projektierern der Windbranche nicht um das Klima sondern nur um das Abgreifen von mehr EEG-Subventionsgeld, das bereits heute mehr als 30 Milliarden Euro jährlich betrage (18a) (siehe auch Abschnitt 6.2)

Für längere Phasen mit nicht ausreichendem Strom aus PV und Wind – also Situationen, in denen auch alle Kurzzeitspeicher erschöpft sind („Dunkelflauten“) – ist eine große Back-up-Kapazität für die Stromerzeugung bereitzustellen. Flexible thermische KWK-Anlagen und Gaskraftwerke sind eine wichtige Säule der Versorgungssicherheit. Dabei nimmt diese benötigte Reservekapazität nicht ab.

2.3.1.1 Windkraft fördert Trockenheit und Erwärmung

Klimaauswirkung.

Lee Miller schätzt die maximal für Windturbinen verfügbare globale Windleistung (ohne die eisbedeckten Regionen) auf 17-38 TW (172). Die Entnahme der Energie durch die Windkraft beeinflusst das Klima, also Temperatur und Regen. Nach den Schätzungen des World Energy Councils (2013) beträgt in 2050 die benötigte globale Gesamtleistung etwa 27 TW (pessimistisches Szenario) .

Forscher der Harvard Universität stellen in einer Studie (18b) fest, dass Windkraftanlagen durch die Veränderung der Durchmischung der Luftschichten in der Vertikalen die Umgebungstemperatur erhöhen. Während eines Zeitraums von einigen Jahrzehnten würde die durch die Politik der Umstellung auf Windenergie verursachte Temperaturerhöhung größer sein als der Nutzeffekt der dabei erzielten CO2 Einsparung.

Schon im Jahre 2004 haben S.Baidya Roy und Kollegen untersucht inwieweit Windparks das lokale Klima verändern können (139). Sie benutzten das Computerprogramm RAMS das die Atmosphäre für Klima – und Wetterforschung modelliert. Das Windrad wird als Energiesenke und Luftturbulenzquelle dargestellt. Der betrachtete Windpark lag in den Great Plains östlich der Rocky Mountains unter dort üblichen Sommerwetterbedingungen. Die Resultate zeigten, dass der Windpark die Windstärke erheblich verringerte. Zusätzlich erzeugten die Turbulenzen Luftwirbel, die den vertikalen Austausch von Wärme und Energie verstärkten, was zu einer Erwärmung und Austrocknung der Luft über der Oberfläche und der Oberfläche selbst führt.

Der Physiker Dr. Peter Adel untersucht zum einen wie die Windräder die feuchtigkeitsspenden Westwinde teilweise ausbremsen und zum anderen, dass die Gesamtheit der in Deutschland vorhandenen Windenergie nicht ausreicht um den Bedarf an erneuerbaren Strom nur annähernd zu decken (140).

Er erwähnt eine Studie von 2011 die abschätzt, dass die weltweite Windenergienutzung auf dem Festland (ohne Polargebiete) maximal etwa 20 Terawatt bereitstellen kann. Umgerechnet auf den Flächenanteil Deutschlands ergibt sich daraus ein Wert von 55 Gigawatt.

Dürrenzunahme

Bei zunehmender Anlagendichte von Windrädern nehmen sich diese gegenseitig den Wind weg. Mit dem Wind wird jedoch im großen Maßstab Feuchtigkeit und Wärme auch über längere Strecken transportiert. Die Windnutzung aber bremst diesen Austausch. Dementsprechend sollten sich mehr Dürren und Wetterextreme ergeben und der Windkraftausbau so genau die negativen Klimaveränderungen fördern, welche die Energiewende eigentlich abwenden soll.

Im Jahre 2018 wurden in Deutschland im Durchschnitt 13 Gigawatt Windstrom erzeugt. Dies entspricht einem Viertel des deutschen Windkraftpotenzials von 55 Gigawatt. In Deutschland konzentriert sich zur Zeit der Ausbau der Windkraft auf Norddeutschland. Das lässt erwarten, dass die Windnutzung dort Wind und Wetter merklich beeinflussen. Entsprechende Veränderungen sind auch bereits messbar. In Osnabrück wurde seit den 60er Jahren ein Rückgang der mittleren Windgeschwindigkeit um 13 Prozent beobachtet.

Eine Studie aus China berichtet, dass gerade in den Gebieten mit intensiver Windkraftnutzung die Windgeschwindigkeit deutlich zurückgegangen ist.

In diesem Zusammenhang fällt auch die Übereinstimmung zwischen der regionalen Windkraftnutzung in Deutschland und der Dürrekarte (Juni 2019) auf, wenn auch für die Dürre nicht nur .( ScienceFiles Kritische Sozialwissenschaften JUNE 25, 2019. das lokale Wetter, sondern auch die Großwetterlage eine entscheidende Rolle spielen dürften.

Links: Dürrezustand Deutschland in einer Bodentiefe von 1,8m ( Dürremonitor des Helmholtz Zentrums für Umweltforschung),

Rechts: Deutschlandweite Verteilung von Windkraftanlagen ( Bundesamt für Naturschutz)

Grundsätzlich lässt aber ein gebremster Luftaustausch eine Abnahme der Niederschläge erwarten.

So behindert ein vorgelagertes Gebirge den Luftaustausch und sorgt dahinter tendenziell für ein kontinentales Klima. Ähnliches ist auch von der Windkraftnutzung zu erwarten.

Darüber hinaus erzeugen Windkraftanlagen Verwirbelungen in der Atmosphäre. Diese beeinflussen über viele Kilometer die Wolkenbildung und den Austausch zwischen den verschiedenen Luftschichten. (Foto s. unten)

Nun werden die Windströmungen auch von natürlichen Hindernissen gebremst und abgelenkt. So verändern nicht nur Gebirge, sondern auch Wälder, Gebäude oder Windschutzstreifen diese Strömungen. Bei der Windenergienutzung wird im Gegensatz dazu dem Wind ein wesentlicher Teil seiner Energie direkt entzogen. Dadurch wird dem Wind weit mehr Energie entzogen als durch die Turbulenzen, die dabei ebenfalls entstehen.

Der oben diskutierte Abschattungseffekt von Windparks wird von Lundquist und Kollegen quantitativ untersucht (141) :

„Windräder bremsen den Wind und verwirbeln die Luft hinter den Rotoren. Genau wegen dieses Wake-Effekts werden einzelne Windräder ja in bestimmten Mindestabständen zueinander aufgestellt. Forscher aus den USA berichten nun in der kommenden Ausgabe von Nature Energy: Diese Zonen reichen weit und können den Ertrag von Parks auf der Leeseite des vorangehenden um bis zu fünf Prozent reduzieren. Das Team stützt sich auf den Vergleich von drei Windparks in Texas, von denen zwei nur wenige hundert Meter voneinander entfernt stehen, aber auch auf atmosphärische und wirtschaftliche Modelle. Der wake-Effekt kann bis zu 50 Kilometer weit reichen, offshore sogar noch weiter. Um unnötige Verluste oder Rechtsstreitigkeiten zu vermeiden, regen die Wissenschaftler an, generell Regeln für den Aufbau von Windparks aufzustellen, die den Einfluss anderer Parks in der Nähe berücksichtigen.

Hierzu die Stellungnahme des deutschen Klimaforschers Prof. Stefan Emeis

Institut für Meteorologie und Klimaforschung (IMK-IFU), Karlsruher Institut für Technologie (KIT), Garmisch-Partenkirchen (142).

„Die Arbeit von Lundquist et al. ist korrekt und wichtig[…]

„Die Arbeit der US-Forscher geht einen wichtigen Schritt weiter als bisherige Arbeiten, in dem sie die wirtschaftliche Auswirkung von Nachläufen für Windparkbetreiber abschätzt, die im Schatten bestehender oder später errichteter Windparks arbeiten müssen. […]

„Die gefundenen finanziellen Einbußen können als Indiz für die Größe der Auswirkungen von Nachläufen auch für deutsche Windparks genommen werden. […]

„Die Existenz der Nachläufe von Windturbinen ist seit Jahrzehnten bekannt. Bei kleineren Windturbinen und Windparks an Land wurde ihr lange Zeit keine große Bedeutung zugemessen. Mit der in den letzten Jahren zunehmenden Größe der einzelnen Windturbinen (Multi-MW Anlagen) und größeren Windparks nimmt die Größe und Länge der Nachläufe zu und wird immer relevanter. Darauf habe ich bereits 2010 hingewiesen und ein einfaches Modell entwickelt, mit dem die Länge von Windpark-Nachläufen abgeschätzt werden kann [2]. Dieses Modell zeigt die Abhängigkeit der Länge von Nachläufen von Untergrundrauigkeit und thermischer Schichtung der Luft. Nachläufe von einigen zehn Kilometer Länge werden damit für Offshore-Windparks bei stabiler Schichtung vorhergesagt. Die Arbeitsgruppe von Frau Lundquist hat schon 2012 Simulationsergebnisse mit dem Strömungsmodell WRF vorgelegt, die teilweise noch längere Nachläufe zeigen [3].

Windkraftanlagen: Der Wind reicht nicht

Peter Adel schätzt die in Deutschland verfügbare Energie ab (140): „Eine durchschnittliche Erzeugung von 50 Gigawatt entspricht einer Jahreserzeugung von 400 Terawattstunden. Der gesamte Energieverbrauch in Deutschland beträgt jedoch 2020 etwa 2500 TWh und soll in Zukunft nach den Prognosen des BMWi sogar noch sinken. https://www.bmwi.de/Redaktion/DE/Publikationen/Wirtschaft/klimagutachten.pdf?__blob=publicationFile&v=8

Somit könnte die Windenergie selbst bei optimalem Ausbau davon höchstens 16 Prozent decken. […]. Mit zunehmender Nutzung wären dadurch zudem umfangreiche Speicher oder andere aufwändige Ausgleichsmaßnahmen für den Windstrom erforderlich.“

Windkraft bremst Hurrikane

Die Entnahme von Windenergie durch Windturbinen wird von Forschern der Stanford Universität sogar als Möglichkeit zur Eindämmung von Hurrikanen in Betracht gezogen (143) (Übersetzung durch Autor). Bitte betrachten Sie auch das Video von Kurt Hickman.

„ Computersimulationen von Mark Jacobsen, Stanford University, zeigen, dass offshore Windparks die Windgeschwindigkeit und die Sturmfluten von großen Hurrikanen deutlich abschwächen können. […]

Die Forscher haben 3 Hurrikane simuliert: Sandy und Isaac, die im Jahre 2012 New York und New Orleans trafen, sowie Katrina, der im Jahre 2005 New Orleans verwüstete. […]

Im Fall von Katrina ergab Jacobson’s Modell, , dass eine Anordnung von 78 000 Windrädern vor der Küste von New Orleans den Hurrikan wesentlich geschwächt hätte bevor er aufs Land traf.Im Computermodell, ergab sich im Fall Katrina, das im Augenblick, wo er aufs Land traf die Windgeschwindigkeit um 36-44 m/sec (zwischen 80 und 98 Meilen/Stunde) abgenommen hatte und die Sturmflutintensität um 79 %. […]

Ein (Autor: finanzieller Anreiz) ist die Verringerung der Schadenskosten .Schäden durch starke Hurrikane, verursacht durch Stürme und Sturmfluten, können sich auf Milliarden von Dollar belaufen. Hurrikan Sandy, zum Beispiel verursachteSchäden von grob 82 Milliarden Dollar in 3 Staaten.

2.3.1.2 Windkraftanlagen: Zerstörung von Waldflächen, Flächenversiegelung

Nach der Agora 2045-Studie beträgt die im Jahre 2045 benötigte Kapazität von Windkraft und Photovoltaik 600 GW. Für 2020 ist nach Angaben des Bundesumweltamts die installierte Kapazität 116 GW.

Bild: Installierte Erneuerbare Energien im Jahre 2045 gemäß der Agora Studie „Klimaneutrales Deutschland 2045“(136)

Betrachtet man nun die Windkraft für sich allein, so ist die in 2045 erforderliche Leistung 145 GW onshore. Heute, 2020, beträgt die installierte Leistung 55 GW onshore, konkretisiert durch 29 600 Windräder.

Bei einer mittleren Windradleistung wie die des heutigen Parks (2MW) bedeutet das zusätzlich 60 000 weitere Windräder. Im Jahre 2018 lag die mittlere Leistung der installierten Rotoren etwas höher bei 3 MW, was die Zahl der noch zu errichtenden Turbinen reduzieren würde.

Was bedeuten das für die abgeschätzten Kapazitäten benötigte Naturflächen.

Der Flächenbedarf für ein Windrad in einem Windpark wird in (21b) mit 0,35 km2 angegeben( Fundament plus die ergänzende Infrastruktur wie Stromtrassen oder Zufahrtswegen). Bereits heute belegen die existierenden 30 000 Windräder eine Fläche von etwa 10 000 km2. Bei einem Zuwachs von 60 000 Windrädern entsteht ein zusätzlicher Flächenbedarf von 21 000 km2. Die gesamte durch die Windräder verlorene Naturlandschaft entspricht ziemlich genau der Fläche Baden-Württembergs.

.Vorher weitgehend geschlossene Wälder werden dadurch zerstückelt, aus dem Ökosystem wird eine Art grünes Industriegebiet (18c).

Es ist sehr schwer Gewichtsdaten für die Windturbinen und die notwendigen Fundamente in den von den Herstellern zur Verfügung gestellten Informationen zu finden. Die Webseite „Ruhrkultur“ (144) führt über die Windmaschine E-126 der Firma Enercon folgende Werte auf:

„Die moderne E 126 erreicht eine Gesamthöhe von fast 200 Metern. Sie benötigt ein Fundament von 1.500 Kubikmetern Beton, der mit 180 Tonnen Stahl armiert ist. Auf dem runden Fundament, das 3.500 Tonnen wiegt, steht der Turm aus konischen Stahlbeton-Segmenten, der 2.800 Tonnen auf die Waage bringt. Das auf dem Turm sitzende Maschinenhaus mit Generator wiegt 340 Tonnen, die Nabe mit den Rotorflügeln aus glasfaserverstärktem Kunststoff noch einmal 320 Tonnen. Damit der Boden das Gesamtgewicht von über 7.000 Tonnen tragen kann, muss er zuvor mithilfe von Schottergranulat, das in 30 Meter tiefe Bohrlöcher gepresst wird, verdichtet werden.“

Das bedeutet, dass mit der Erstellung der zusätzlichen 60 00 Windräder eine Betonmasse von 3500t x 60 000= 210 Millionen t dauerhaft (siehe Recyling) in den Boden versenkt wird.

Bei einer CO2-Emission von 340 kg für die Herstellung von 1m3 Beton (2,5 t) (173) ist dies ein CO2-Gesamtausstoss von 30 Millionen t.

Quelle: http://windwahn.net/ein-windrad-steht-im-walde/

2.3.1.3 Windkraftanlagen: Artenschutz

Die etwa 30 000 Windräder in Deutschland, die heute in Deutschland installiert sind, töten nach (18d) pro Jahr

250 000 Fledermäuse, 12 000 seltene Greifvögel und 1 200 t Insekten .

Eine Studie über die gesamten USA (Auswertung 45 000 Turbinen) ergibt eine jährliche Kollisionsrate pro Windrad zwischen etwa 3 (Great Plains) und ca 8 (Kalifornien) Zusammenstößen (18e) . Überträgt man in grober Näherung einen Mittelwert von ca 5. Kollisionen pro Windrad auf die 30 00 Windräder, die sich aktuell in Deutschland drehen , so erhält man ca 150 000 getötete Vögel pro Jahr.

Die weltweit bisher (2016) größte Studie zu Kollisionsrisiken von Vögeln mit Windrädern mit Schwerpunkt Schleswig-Holstein (Auftraggeber Bundeswirtschaftsministerium) stellt allein für das nördlichste Bundesland mit etwa 3000 Windrädern jährlich 1600 tote Mäusebussarde durch Windkraftanlagen fest (18f)

Leben bedrohte Arten wie der Schwarzstorch oder verschiedene Greifvogelarten (roter Milan, Mäusebussard), im Umfeld eines geplanten Projekts, so müssen die Erzeuger entsprechende Abstände einhalten, oder ihre Pläne werden nicht genehmigt. Nach (18c) kommt es zu illegalen Zerstörungen von Großvogelhorsten in der Nähe von bestehenden und geplanten Windkraftanlagen.

Die Umweltministerkonferenz aus Bund und Ländern hat im Mai 2020 diskutiert wie die Hemmnisse des Ausbaus der Windkraft beseitigt werden können. Es wird u.a. ein Vorschlag erarbeitet ,wie genehmigungshemmende Abstände zu Vogellebensräumen verringert werden können (18g).

2.3.1.4 Windkraftanlagen: Abbau, Recycling, Abrissfinanzierung

Die FAZ berichtet (18h), dass das Umweltbundesamt (UBA) ab 2021 mit einem verstärkten Abriss der etwa 30 000 Anlagen rechnet. Die im Rahmen einer UBA Studie errechneten Abfallmengen sind extrem gross: 5,5 Millionen Tonnen Beton pro Jahr, vor allem wegen der Fundamente, müssen ausgegraben und beseitigt werden. Zudem fielen knapp eine Million Tonnen Stahl pro Jahr an , was grundsätzlich gut zu verarbeiten sein müsste. Anders sieht es aus bei den mit Kohlefasern verstärkten Rotorblättern. Die Recyclingbranche hatte hier mit dem Hinweis auf Sondermüll schon vor Jahren Alarm geschlagen. Laut Prognose für das UBA werden hier ab 2024 „relevante Mengen“ von bis zu 70.000 Tonnen pro Jahr anfallen. Sie seien nicht nur schwer zu verwerten, in ganz Deutschland gebe es auch nur eine einzige Verwertungsanlage für solche Abfälle. Auch Bloomberg (18j) schreibt Anfang 2020 einen ausführlichen Artikel über die Schwierigkeiten den Restmüllverwertung der Rotorblätter mit den Dimensionen eines Flügels des Großraumfliegers 747/Jumbo Jet.

Die FAZ berichtet weiter, dass nach der Studie für den Rückbau der Windenergieanlagen eine große Finanzierungslücke zu erwarten ist. Die Betreiber könnten – obwohl seit 20 Jahren von den Stromkunden mit mehr als 100 Milliarden Euro subventioniert – nicht genügend Rückstellungen für den Rückbau gebildet haben.

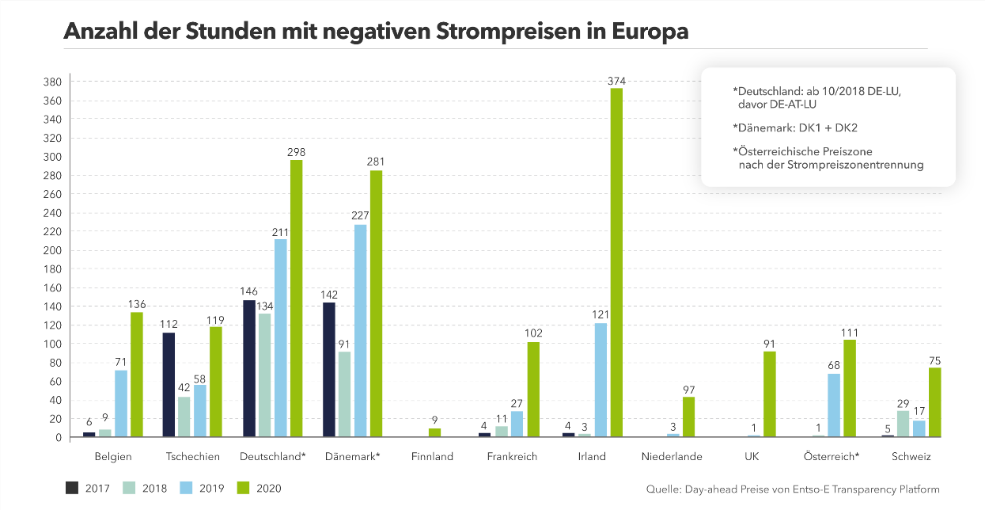

Die fluktuierende Erzeugung erneuerbarer Energien kennt natürlich nicht nur Perioden mit nicht ausreichender Versorgung ,sondern auch Tage, in denen mehr Strom als in Deutschland benötigt produziert wird. In dieser Situation zahlt Deutschland an die ausländischen Abnehmer sog. Entsorgungsgebühren: Diese Entsorgungsgebühren zahlt der deutsche Steuerzahler, während sich der ausländische Verbraucher am kostengünstigen Überschussstrom erfreuen kann (19).

2.3.1.5 Stromnetze für die Energiewende

In vielen Artikeln und Veröffentlichungen über die Energiewende wird die Erzeugung der Erneuerbaren Energien behandelt aber nicht die tausend Kilometer Stromtrassen, die den grünen Strom zum Verbraucher bringen. Sehr klar ist eine Veröffentlichung des Ministeriums für Wirtschaft und Klimaschutz und die darin enthaltenen Links. Einige Zitate aus dem Text:

„So wird etwa der erneuerbare Strom aus Windenergie vorrangig im Norden und Osten sowie auf See erzeugt, wo der Wind besonders stark weht. Die größten Stromverbraucher – allen voran große Industriebetriebe – befinden sich aber im Süden und Westen Deutschlands. Der im Norden erzeugte „Windstrom“ muss also dorthin transportiert werden.

[…] Insgesamt müssen in den nächsten Jahren über 7.500 Kilometer im Übertragungsnetz optimiert, verstärkt oder neu gebaut werden. Eine besondere Rolle spielen hierbei die Höchstspannungs-Gleichstrom-Übertragungsleitungen (HGÜ-Leitungen), die sogenannten Stromautobahnen, wie SuedLink oder SuedOstLink. Auch der Ausbau der Verbindungen zu unseren europäischen Nachbarn wird immer wichtiger, denn die Energiewende ist zunehmend europäisch eingebettet. So können wir etwa Wasserkraft in Skandinavien und den Alpenländern mit Windkraft und Photovoltaik in Deutschland verbinden. Damit senken wir die Kosten der Energiewende.

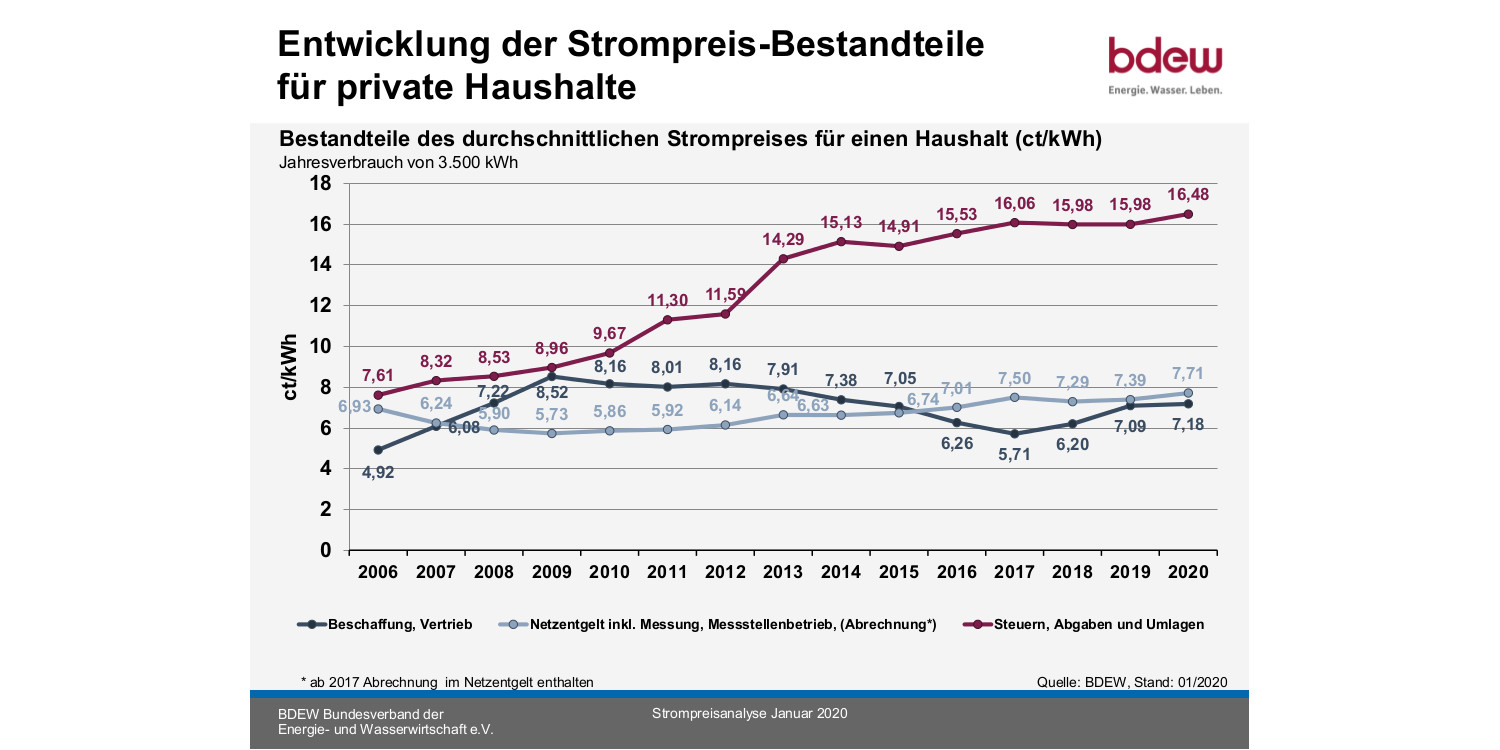

Beim Strompreis ist dies allerdings ein kostenerhöhender Faktor

2.3.2 Ärzte warnen vor Gesundheitsrisiko durch Windräder

2.3.2.1 BGR-Studie, kein Zusammenhang mit der Gesundheit. Lobbyvertreter ziehen die falschen Schlüsse

Überraschend wenig Beachtung hat in den Medien die gesundheitliche Gefährdung durch Windräder gefunden, vor der in zunehmendem Maß die Mediziner warnen.

Auf der Webseite „Welt“ schreibt Daniel Wetzel (145):

„Nach einer fehlerhaften Berechnung des Schalldrucks von Windkraftanlagen durch das Bundesamt für Geowissenschaften und Rohstoffe (BGR) warnen Mediziner vor höheren Gesundheitsgefahren. „Offenbar ist Windkraft schon bei niedrigeren Schalldrucken gefährlicher als bisher angenommen“, sagte Christian-Friedrich Vahl, langjähriger Direktor der Klinik für Herz-, Thorax- und Gefäßchirurgie an der Universität Mainz gegenüber der „Welt am Sonntag.[…]

Das BGR hatte in der vergangenen Woche eingeräumt, die Schallemissionen von Windrädern nach einer Datenerhebung im Jahre 2004 zu hoch angegeben zu haben.“

Nach (146) bemerkte das BGR : „Die Studie habe lediglich zum Ziel gehabt, eine mögliche Beeinträchtigung einer BGR-Messstelle zur Überwachung von weltweiten Atomwaffentests durch Windräder zu vermeiden. „Ein unsachgerechtes Einbringen dieses Sachverhaltes in andere Kontexte durch Interessensgruppen ist zu bedauern, jedoch seitens der BGR nicht zu verhindern“, so ein Sprecher. Bei der Studie gehe es ohnehin ausdrücklich nicht um Auswirkungen auf den menschlichen Organismus“.

Daniel Wetzel schreibt weiter:

„Lobbyvertreter forderten als Konsequenz von der Bundesregierung, den Mindestabstand zwischen Windrädern und Wohnbebauung noch weiter zu verringern. Die frühere Grünen-Chefin und Präsidentin des Bundesverbandes Erneuerbare Energie, Simone Peter, sah darin einen angeblichen Beleg für die gesundheitliche Unbedenklichkeit von Windkraftanlagen.

Das Gegenteil sei jedoch der Fall, sagte Vahl, der als Leiter der Arbeitsgruppe Infraschall der Universitätsmedizin Mainz seit Jahren die Wirkung von Infraschall auf Zellgewebe und Organe erforscht: „Nach der BGR-Korrektur werden die Beschwerden der Betroffenen nicht mehr im Bereich von größer 90 Dezibel geäußert, sondern bereits im Bereich zwischen 60 bis 70 Dezibel. “ (siehe auch unten dBA nicht geeignet)

Weil Windkraftanlagen heute zudem sehr viel größer sind als im Untersuchungszeitraum 2004, sei es umso dringlicher, die gesundheitlichen Auswirkungen von Infraschall eingehend zu untersuchen, sagte Vahl. Die modernen, größeren Anlagen „emittieren einen erheblich höheren Schalldruck, außerdem verschiebt sich die Emission zu niedrigeren Frequenzen, die sehr wahrscheinlich ein höheres Gesundheitsrisiko bewirken.“ […]

Die Korrektur der BGR ändert nicht die grundsätzlichen Stresswirkungen von Infraschall, die auf verschiedenen Ebenen des Organismus gefunden wurden“, sagte Vahl. Der Mediziner nannte beispielhaft „Wirkungen bei Membranstrukturen und der zellulären Kommunikation, im Gleichgewichtssystem und bei Aktivierung distinkter Gehirnbereiche im Unterbewusstsein.“

2.3.2.2 Definition von Infraschall

Das Deutsche Ärzteblatt fasst die Definition des Infraschalls und einige seiner wichtigen Eigenschaften zusammen (147).

„Infraschall ist Schall unterhalb der Frequenz von 20 Hertz. Geräusche unter 20 Hertz nimmt das Ohr erst bei viel höheren Schalldruckpegeln wahr als den hörbaren Schall von 20 bis 20 0000 Hertz: Je tiefer die Frequenz, desto höher muss somit der Schalldruckpegel (quasi die Lautstärke) sein, damit das Hörorgan einen Sinneseindruck erhält. Bei 8 Hertz zum Beispiel muss der Schalldruckpegel bei 100 Dezibel liegen, damit die Wahrnehmungsschwelle erreicht ist. (26).

Die großen Wellenlängen können zu Resonanzphänomen innerhalb und außerhalb von Häusern führen (2).

Die Unterschiede in der individuellen Hörschwelle sind im Infraschallbereich stärker ausgeprägt als im Bereich des hörbaren Schalls. Manche Menschen nehmen daher Infraschall bei hohem Schalldruckpegel als Brummen wahr, andere nicht. Niedrigfrequente Körpervibrationen können bei hohen Schalldruckpegeln gefühlt werden.

Aufgrund seiner großen Wellenlängen von Hunderten Kilometern wird Infraschall kaum von der Luft oder dem Boden gedämpft und auch nicht durch Hindernisse wie Felsen, Schutzwälle, Bäume oder Gebäude abgeschirmt – er breitet sich nahezu verlustfrei aus (27). Verdoppelt sich die Entfernung, so nimmt der Schallpegel um 6 Dezibel ab (siehe Grafik). So konnten Schallphänomene von einem Park mit 60 Windturbinen noch in 90 Kilometer Entfernung nachgewiesen werden (28).

In geräuscharmer Umgebung reagiert das Ohr sensitiver auf Infraschall. Ein ruhiges Zuhause kann so zum Problem werden, da der hörbare Schall der Windturbinen durch Mauern gedämpft wird, Infraschall dagegen nicht. Und wer mit dem Ohr auf dem Kissen schläft, blockiert auf dieser Seite den hörbaren Schall, aber nicht den Infraschall (29)“

2.3.2.3 Infraschall: Wie nimmt der Mensch den unhörbaren Schall wahr

Die Professoren der HNO Heilkunde der Washington Universität in St. Louis Alec N. Salt and Jeffery T. Lichtenhan veröffentlichen eine wissenschaftliche Arbeit über den Infraschall und untersuchen die Frage warum der niederfrequente Schall, obwohl man ihn nicht hören kann, trotzdem physiologisch wirkt (155).

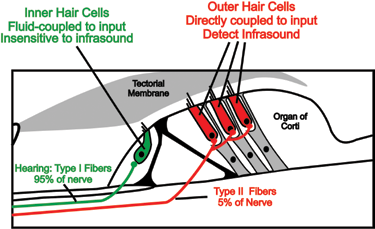

Bild:Die Anatomie der Hörschnecke: Innere und äussere Haarzellen und Nervenfasern

Die Hörschnecke im Innenohr ist mit inneren und äußeren Haarzellen ausgestattet. Die inneren Haarzellen vermitteln das Hören und sind unempfindlich für niederfrequenten Infraschall. Die äusseren Haarzellen dagegen sind in Kontakt mit der Tektorialmembran und sprechen auf niederfrequenten Schall und Infraschall an.

„ Wir haben beschrieben […]wie Infraschall und niederfrequenter -Schall Anlass für die Symptome sein können , über die Personen berichten die in der Nähe von Windrädern leben. […] Ein Problembereich ist die Rolle die Akustik-Ingenieure gespielt haben. Jahrlang haben sie sich hinter das Mantra zurückgezogen, das sich jetzt als falcch erweist, das sich in Aussagen widerspiegelt wie „ Was du nicht hören kannst, das kann Dir nicht schaden“, „ Infraschall von Windrädern ist unterhalb der Hörschwelle“ […] „ Ich kann kategorisch erklären das die aktuelle Konstruktion von Windrädern keine bedeutsamen Infraschall erzeugt“, Alle diese Feststellungen nehmen an , dass das Hören basierend auf den inneren Haarzellen der einzige Mechanismus ist wie der niederfrequent Schall den menschlichen Körper beeinflussen kann. Wir wissen , dass diese Annahme falsch ist und machen dafür die fehlende Kenntnis der Physiologie verantwortlich.“

Salt schreibt weiter daß die dBA -gewichtete Schallmessung nicht akzeptabel ist, da sie in grober Weise die Lärmeinwirkung auf das Innenohr falsch beurteilt.

2.3.2.4 Die gesundheitlichen Probleme von Windrad- Anwohnern

Aus der Vielzahl der Meldungen über Klagen von Anwohnern von Windkraftanlagen über gesundheitliche Beeinträchtigungen und Verlust der Lebensqualität werden zwei Studien aus Kanada und Australien herausgegriffen. Sie erfassen quantitativ wie die betroffenen Personen ihre gesundheitlichen Probleme empfinden.

Kanada

Der erste Fragebogen war im Jahre 2009 an verschieden Orte der kanadischen Provinz Ontario gesandt worden, wo Klagen über die Beeinträchtigung der Gesundheit und der Lebensqualität durch angrenzende Windkraftanlagen laut geworden waren (148). Die verantwortliche Projekt WindVOiCe war gegründet worden, um den Bewohnern eine Möglichkeit zu geben ihre Probleme zu artikulieren, da individuelle Beschwerden von Regierungsorganisationen und Industrie ignoriert worden waren. Hinsichtlich der Methodik unterstreichen die Autoren die Bedeutung von Fragebogen zur Selbstbeurteilung im Rahmen wissenschaftlicher medizinischer Untersuchungen wie z.B. beim Brustkrebs-Monitoring als Ergänzung zur Mammografie. Die Auswertung dieser subjektiven Daten ergeben wertvolle Indikationen für epidemiologische Studien im grösseren Massstab, die leider kaum Existieren (dt Ärzteblatt)

Die nachfolgende Tabelle listet die verschiedenen Beschwerden der 102 Probanden der Ontario- Studie auf.

Dabei sind die Beschwerden in der ersten Spalte aufgeführt und ihre relative Häufigkeit wird nach dem Abstand der Wohnung vom Windrad in m in der obersten Spalte unterschieden.

Die Größe p der letzten Spalte gibt das Signifikanzniveau des Ergebnisses an. Ein Wert von 0.0778 beispielsweise bei „disturbed sleep“ bedeutet, dass die Wahrscheinlichkeit das Schlafstörungen bei allen Bewohnern in der Nähe von Windkraftanlagen auftreten, (1-p) also etwa 92 % beträgt.

In den Kommentaren findet man Personen bei denen die subjektiven Beschwerden so stark waren, dass Sie ihr Heim dauerhaft verlassen haben, manchmal mit finanziellen Problemen durch den Werteverlust ihres Hauses bzw durch die Notwendigkeit 2 Wohnungen zu finanzieren (Appendix E).

Australien

Eine weitere sehr eingehende Untersuchung „Lärmemissionen von Windparks und menschliche Wahrnehmung“ wurde 2014 von der australischen Regierung veranlasst (149).

Das Studienteam bestand aus Experten der Gebiete Akustik, Psychoakustik, Psychologie, Allgemeinmedizin, Statistik und Philosophie. Die Probanden waren Anwohner im Umkreis von 3500 m von von 2 Windparks, die ihre Situation im Hinblick auf ihre Schallbeeinträchtigung mit Hilfe genormter Fragebogen selbst beurteilten. Die 25 Teilnehmer wurden auf Grund von Gesundheitsbeschwerden rekrutiert, die im Rahmen von eidesstattlichen Erklärungen, Anhörungen oder durch Interviews im Rahmen der Studie erfasst wurden. Die Studie umfasste Fragebögen zur Selbstbeurteilung durch die Versuchspersonen hinsichtlich ihrer gesundheitsbezogenen Lebensqualität (genormte Fragebogen HRQOL und SF-36), ihrer Lärmempfindlichkeit (genormter Fragebogen NoiSeQ) und ihrer Schlafqualität ( genormter Fragebogen PSQI) (Für die Details der Normen der Fragebögen siehe Wikipedia in Englisch)

Die multidisziplinäre Studiengruppe kommt zu dem Ergebnis, dass die Probanden der Studie durch die Windrad-Aktivität in ihrer Gesundheit beeinträchtigt sind. Unterschiedliche Personen können beim gleichen Lärmpegel, aufgrund unterschiedlicher Lärmempfindlichkeit, unterschiedliche Stressreaktionen zeigen.

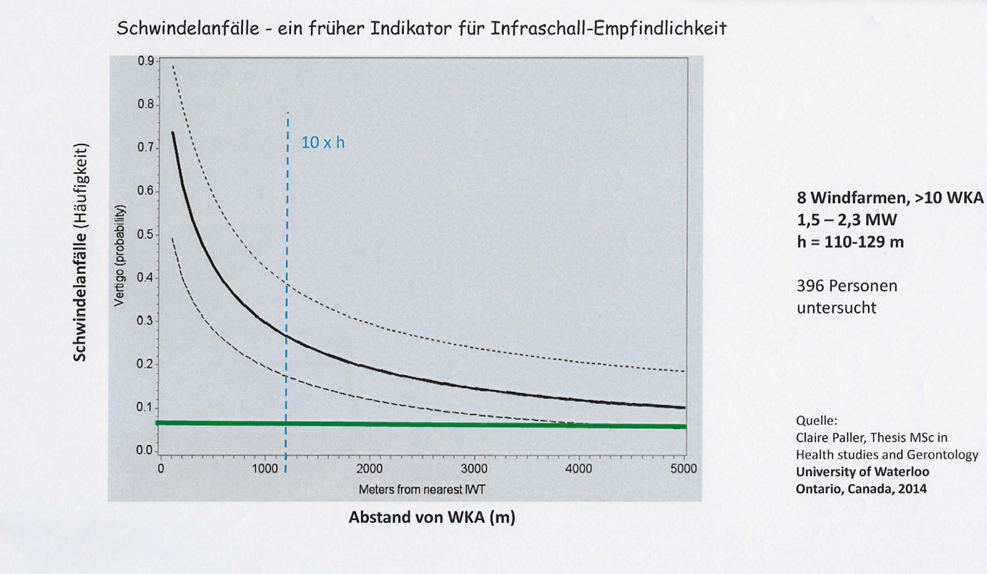

In der Doktorarbeit von Claire Paller (150) ist die Abhängigkeit der Schwindelanfälle vom Abstand zur Windkraftanlage dargestellt. Dargestellt sind der Mittelwert sowie drunter und untere 95% Vertrauensbereich, Die Abhängigkeit ist statistisch signifikant mit P<0,001.

Die Personen, die in der Nähe von Windrädern wohnen, haben eine verminderte gesundheitsbezogene Lebensqualität auf Grund von Stress und Schlafstörungen und ihre Gesundheit kann durch die Lärmemissionen merklich und ernsthaft beeinträchtigt werden.

Auf Grundlage der Ergebnisse kann angenommen werden, dass für bestimmte Personen, wenn sie den durch Windräder erzeugten Lärmemissionen und Luftdruckschwankungen ausgesetzt sind, ein ernsthaftes Risiko für ihre Gesundheit besteht. Ernsthaftes Risiko für ihre Gesundheit bedeutet z. B. dass die betroffene Person sich gezwungen fühlt ihren Wohnort zu wechseln, um den Lärmstress zu verringern.

2.3.2.5 Das Vibroakustische Syndrom

Medizinische Veröffentlichungen zeigen, dass der Schall nicht nur über die Hörfunktion sondern auch über druckempfindlich Areale des ganzen Körpers auf den Menschen einwirkt.

Umfassend wird die gesamte Problematik der Auswirkungen des Infraschalls auf die Gesundheit und der zur Bewertung angewandten Messungen von der Internistin Dr. Dagmar Schmucker erklärt: “Infraschall und Vibroakustisches Syndrom- Altbekannte Phänomene in neuem Zusammenhang!“ (151)

„Die Übertragung von Infraschall, Schall und tieffrequentem Schall erfolgt in der Luft als sogenannter (primärer) Luftschall. Bei Körperschall hingegen handelt es sich um meist tieffrequente Schwingungen (Vibrationen), die in festen Stoffen (z. B. Boden, Fundamente, Rohrleitungen, Wände) übertragen werden.[…]

Komplizierend zur alleinigen Auswirkung von Infraschall muss immer auch der durch Vibration entstehende Körperschall berücksichtigt werden.[…]

Eine Sonderform ist der Infraschall ausgelöst durch Windradanlagen, da diese gepulst sind. Die Pulsung entsteht durch das Vorbeistreifen des Windrades am Mast – dadurch werden große Luftdruckänderungen verursacht. An der Spitze eines Windradflügels entstehen Riesenkräfte durch die hohen Geschwindigkeiten, die bis zu 400 km/h betragen können. Diese Frequenzspitzen spielen bei der Wahrnehmung des Infraschalls eine große Rolle, da diese unerwartet auftreten. Auch Gehörlose können Infraschall wahrnehmen, gerade hier findet die Wahrnehmung über den Körper statt (z. B. Bässe in der Disco)“

Schmucker bezeichnet die TA Lärm zur Bestimmung des zu beurteilenden Schalldruckpegels als veraltet, da die empfohlene dB A -Bewertung die tiefen Schallfrequenzen wegfiltert.

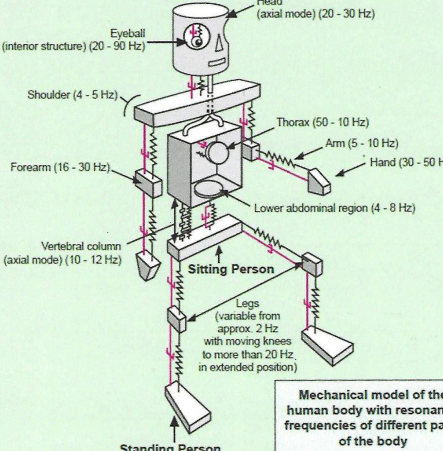

Die Organe und Skelettteile des menschlichen Körpers besitzen bestimmte Eigenfrequenzen , die durch den tieffrequenten Infraschall zu erzwungenen Schwingungen angeregt werden und zum Auftreten von gesundheitsgefährdenden Resonanzphänomenen (Vibroakustisches Syndrom) führen können

„Die Analyse des menschlichen Körpers als mechanisches System zeigt, dass er als relativ kompliziertes System von Masse-Feder-Teilsystemen interpretiert werden kann. Jedes Teilsystem hat seine eigene Resonanzfrequenz und die Wechselwirkung zwischen den Teilsystemen hängt zusätzlich von der Körperhaltung ab (sitzen, liegen, ETC). Die Schulterpartie hat eine Eigenfrequenz von 4 – 5 Hz, der Unterbauch von 4 – 8 Hz.

Legt sich jetzt ein Mensch in ein durch Körperschall niedrigfrequent schwingendes Bett, so tritt ein Resonanzphänomen auf und diese Körperteile schwingen mit. Dieses Mitschwingen ist nur durch Aufwendung von Muskelspannung unterbrechbar, was nicht schlafförderlich ist.“

Zum Thema der Körpervibrationen und der Resonanz mit Infraschall schreibt der Biopsychologe Michael Persinger (152) dass die Frequenzen des Infraschalls mit dem menschlichen Körper in Resonanz treten können, Der Grund ist, dass die Eigenfrequenzen des menschlichen Körpers und seiner Organe im Bereich des niederfrquenten und Infraschalls liegen. Es lassen sich Korrelationen zwischen Infraschall und Beschwerden wie Übelkeit, Müdigkeit, unklaren Schmerzzuständen und Schlafstörungen feststellen.

Die Amplituden der Mikrovibrationen des menschlichen Körpers liegen zwischen 1-5 µm, bei angespannter Muskulatur sogar bis zu 50 µm. Zum Vergleich sind die Auslenkungen des Trommelfells bei 1kHz und 90 dB Schalldruckpegel nur 0,3 µm.

Bei Resonanz zwischen dem menschlichen Körper und dem Infraschall ist weniger die Stärke des Schallstimulus als seine Frequenz entscheidend.

Die Frequenz zwischen 1 und 4 Hz ist die Frequenz der Deltawellen des menschlichen Gehirns (im Elektroenzephalogramm) hängt mit der Tiefschlafphase zusammen. Störungen dieser Schlafphase können die Hormonausschüttungen und das Gleichgewicht der Organfunktionen (Homöostase) beeinträchtigen.

Persinger weist auf die starke Unterschätzung des Schalldrucks von Windrädern hin und verweist auf eine Studie von Salt und Kaltenbach (2011) hin, wo in einem Beispiel für 10 Hz bei einer Windturbine ein unbewerteter Schalldruck von 60 dB gemessen wurde dagegen A-bewertet (s. unten Schallbewertung) keine Schalldruckpegel gemessen wurd ).

Die Empfindlichkeit auf Infraschall innerhalb der Personengesamtheit ist stark unterschiedlich.

2.3.2.6 Infraschall: Veränderung von Herz- und Hirnfunktion

Mit zunehmender Zahl der akustischen und medizinischen Untersuchungen der gesundheitlichen Wirkung des Infraschalls und des Infraschalls im Zusammenhang mit Windrädern haben sich auch die Medien mit diesem Aspekt befasst.

Während Robert W. Endlich ( Vibro-Acoustic-Disease, A Story About VAD, Infrasound Effects (casf.me)

die Etappen der Erforschung des Vibroakustischen Syndroms an Hand von Fallbeispielen in verschiedenen Ländern der Welt beschreibt (153), stellt Sherri Lange auf dem Internetforum „Free-Market Energy “ spezielle medizinisch-wissenschaftliche Veröffentlichungen zum Thema Gesundheit und Infraschall zusammen (154).

Unter dem Titel“ „Infrasound: A Growing Liability for Wind Power“ also „Infraschall , eine zunehmende Verantwortung der Windenergie“ wird zuerst ein Video interview mit einigen prominenten medizinischen Fachleuten zu diesem Thema aufgeführt.

Im weiteren Text des Sherri Lange Artikels werden wissenschaftlich Veröffentlichungen, die sich mit dem Infraschall befassen, vorgestellt.

Einwirkung auf den Herzmuskel

Eine Ende 2021 erschienene Veröffentlichung Taiwanesischer Wissenschaftler

„Effects of low-frequency noise from wind turbines on heart rate variability in healthy individuals“

untersucht den Einfluss tieffrequenten Schalls von Windrädern auf die Herzfrequenzvariabilität (heart rate variability). Die Studie stellt eine anomale Reduzierung der Standardabweichung in den R-R- Abständen ((Herzfrequenzvariabilität) der Elektrokardiodiagramme der Versuchspersonen fest.

Die Herzfrequenzvariabilität ist ein physiologisches Phänomen der Schwankung des Zeitintervalls zwischen zwei aufeinanderfolgenden Herzschlägen in Millisekunden.

Im EKG ist es die Schwankung des R-R- Intervalls im QRS- Komplex

Fig. 1 Ein EKG zeigt eine Serie von QRS- Komplexen . Die Zeit zwischen den Herzschlägen (R-R- Intervall) schwankt naturgemäß von Schlag zu Schlag.

Die HRV nimmt naturgemäß während Stresssituationen ab . So ist die HRV typischerweise höher, wenn das Herz langsam schlägt und niedriger, wenn das Herz schneller schlägt, zum Beispiel bei Stress oder körperlicher Anstrengung.

Eine hohe HRV wird generell als Zeichen eines gesunden Herzens betrachtet und eine höhere HRV ist in vielen Studien mit einer geringeren Krankheitsanfälligkeit und Sterblichkeitsrate sowie erhöhtem psychologischen Wohlbefinden und höherer Lebensqualität verknüpft.

Diese Studie bestätigt die Untersuchungen von Professor Vahl zum schädlichen Einfluss des Infraschalls von Windkraftanlagen auf den menschlichen Myokardmuskel ( Studie 1 , Studie 2 )

Diese Untersuchungen wurden bereits im Abschnitt „Lobbyvertreter und Medien ziehen die falschen Schlüsse“ angesprochen. “Ob wir es hören oder nicht, jede Form der Energie hat physikalische Auswirkungen und Infraschall ist besonders gefährlich, weil wir ihn nicht hören.“

„Schlaflosigkeit, Herzprobleme, Wahrnehmungsstörungen, Schwindelanfälle sind nur ein Teil der Krankheitssymptome, die durch Infraschall verursacht werden können.“

Infraschall beeinflusst die Hirnströme

Die Studie von Markus Weichenberger und Kollegen „Altered cortical and subcortical connectivity due to infrasound administered near the hearing threshold – Evidence from fMRI“ untersucht die Hirnaktivität bei Einwirkung von Infraschall mit Hilfe von Magnetresonanztomografie (157).

Die Wissenschaftler resümieren, dass längere Exposition mit Infraschall in der Nähe der individuellen Hörschwelle zu einer stärkeren funktionellen Konnektivität von verschiedenen Gehirnarealen führt, wie mit Hilfe der funktionellen Magnetresonanztomografie gezeigt werden kann. Die Studie zeigt nicht nur, dass Infraschall physiologische Wirkungen hat, sondern dass Gehirnbereiche aktiviert werden, die nicht nur für den Gehörvorgang sondern auch für die emotionale Steuerung und das vegetative Nervensystem zuständig sind. Die Ergebnisse legen somit nahe, dass unter der Hörschwelle liegender Infraschall, Anlass für eine Reihe von physiologischen und psychologischen Gesundheitsproblem führen kann, die bisher nur oberflächlich mit dem niederfrequenten und dem stark niederfrequenten Spektrum in Verbindung gebracht wurden.

Definition von funktioneller Konnektivität

Verändert sich die Aktivität der Nervenzellen in zwei oder mehreren Hirnregionen zeitlich synchron, gehen Wissenschaftler davon aus, dass sie Netzwerke bilden und miteinander kommunizieren. Sie sprechen dann von einer funktionellen Konnektivität, die sie mittels funktioneller Magnetresonanztomografie (fMRT) auch bildlich erfassen können

UBA- Studie

Dagegen schliesst eine Experimentalstudie des Umweltbundesamts:

„Infraschall um oder unter der Wahrnehmungsschwelle führt nicht zu unmittelbaren körperlichen Reaktionen zeigt aber Belästigungswirkung“

„Die Experimentalstudie wurde unter weitreichend kontrollierten Bedingungen auf einem ehemaligen Kasernengelände bei Flensburg durchgeführt. Insgesamt 44 Personen wurden innerhalb von circa acht Stunden mit vier unterschiedlichen Infraschallgeräuschen beschallt. Die Beschallungsdauer betrug je 30 Minuten. Während und nach der Beschallung wurden die physiologischen Parameter Herzfrequenz, Blutdruck, Hirnrinden-Aktivität und Gleichgewichtswahrnehmung gemessen. Dabei konnten keine statistisch signifikanten Veränderungen festgestellt werden, die auf Infraschall zurückzuführen waren. […]

Allerdings wurde die Studie als Experimentaluntersuchung mit einer geringen Anzahl von Versuchspersonen und einem vergleichsweise kurzen Beschallungszeitraum mit synthetischen reinen Infraschallsignalen durchgeführt. Daher können die Forschungsergebnisse nicht generalisiert und daraus keine möglichen langfristigen gesundheitlichen Auswirkungen von Infraschallimmissionen im Wohnumfeld abgeleitet werden. Um mögliche bislang nicht bekannte Langzeiteffekte zu identifizieren, bedarf es einer epidemiologischen Langzeitstudie im Wohnumfeld. Das Umweltbundesamt beabsichtigt daher, im kommenden Jahr ein vorbereitendes Forschungsvorhaben zu diesem Thema durchzuführen.“

Zu dieser letztgenannten Studie des UBA konnten auf dem Internet keine Informationen gefunden werden.

Infraschall, getestet für Waffenentwicklung

In dem Artikel von Sherri Lange wird erwähnt, dass im allgemeinen 10 bis 30% der Personen Beschwerden durch Infraschall angeben. John B. Alexander, der in der Zeit des kalten Krieges in der US army für die „Entwicklung unorthodoxer Waffen“ verantwortlich war, berichtete, dass Infraschall bei einigen Personen Übelkeit, Schwindel Unfähigkeit klar zu denken auslöste, andere Personen davon aber nicht betroffen waren, so dass diese Waffenentwicklung eingestellt wurde.

2.3.2.7 Der Nocebo Effekt und die Windkraftindustrie

Das deutsche Ärzteblatt erörtert die Problematik der Windkraftanwohner (147)

„Ob nun hörbar oder nicht – Anwohner in der Nähe von WEA machen Infraschall für zahlreiche gesundheitliche Probleme verantwortlich: Erschöpfung, Schlaflosigkeit, Kopfschmerzen, Atemnot, Depressionen, Rhythmusstörungen, Übelkeit, Tinnitus, Schwindel, Ohrenschmerzen, Seh- und Hörstörungen und etliche andere. Aber die Ergebnisse sind höchst inkonsistent. So zeigen zum Beispiel polysomnografische Untersuchungen zum Schlafverhalten, dass sowohl hörbare als auch nicht hörbare Schallphänomene im Umfeld von Windrädern keine nennenswerten Auswirkungen auf das Schlafverhalten haben (6). Die ebenso unspezifischen wie zahlreichen Beschwerden gaben von Anfang an Anlass zur Skepsis. Das Team um den klinischen Psychologen Prof. Dr. Keith J. Petrie von der Universität Auckland in Neuseeland hat die Frage untersucht, ob die Psyche angesichts eines Windrades in der Nachbarschaft das Krankheitsempfinden triggert.

Nocebo-getriggerte Symptome

Petrie kann zeigen, dass Negativ-informationen über Windräder ungute Erwartungen triggern und dies eher Symptome verursacht als der Infraschall selbst: 2009 erschien das Buch „Wind Turbine Syndrome – A natural Experiment“ in Australien, das Infraschall von Windturbinen für eine Reihe von Störungen verantwortlich macht. In Petries Studie wurden die Lärmbeschwerden über 51 Windkraftanlagen in Australien aus 2 unterschiedlichen Zeiträumen miteinander verglichen: Einmal aus 1993–2008 vor Erscheinen des Buches, einmal von 2009–2013 danach. 90 % derjenigen, die sich beschwerten, taten dies ab 2009 (7).

Die Arbeitsgruppe um Petrie hat in weiteren Studien mit Placebo-Infraschall die durch negative Erwartungshaltung beeinflussten Symptome untersucht und Nocebo-Effekte belegt (8, 9).

Allerdings erklärt die Psyche die Beschwerden vermutlich nicht allein. Immer öfter zeigen Beobachtungen an den unterschiedlichsten Organen, dass es messbare Effekte von Infraschall gibt. Vergleichsweise gut untersucht wurde die Frage, ob Schall unterhalb der Hörschwelle Auswirkungen auf das Innenohr hat. Die Studien von Prof. Dr. Alec Salt von der Washington University School of Medicine in St. Louis zeigen, dass die äußeren Haarzellen der Cochlea direkt auf Veränderungen der Tektorialmembran im Innenohr reagieren, da sie mechanisch gekoppelt sind. Die äußeren Haarzellen können somit durch sehr tiefe Frequenzen angeregt werden. Anders ist es bei den inneren Haarzellen, deren Bewegung über Flüssigkeit vermittelt wird (10). Da aber die äußeren Haarzellen die Perzeptionsschwelle der inneren Haarzellen modulieren können, ist ein mittelbarer Effekt von Infraschall auf das Hören zumindest denkbar.

Parallelen zur Seekrankheit

Unter bestimmten Bedingungen, etwa beim endolymphatischen Hydrops im Innenohr (Morbus Menière), nach Barotrauma oder einem vergrößerten vestibulären Aquädukt könnte das Ohr empfindlicher auf Infraschall reagieren. Das liefert dem kanadischen Otolaryngologen Robert V. Harrison von der Universität Toronto eine Erklärung für das „Wind Turbine Syndrome“ (11). Dieses ist durch Symptome wie Schwindel, Übelkeit und Nystagmus gekennzeichnet.

Harrison erläutert, wie bei ansonsten symptomlosen Menschen Anomalien im Gleichgewichtsorgan, die sich als eine Dehiszenz im superioren (semizirkularen) Vestibularkanal im CT zeigen, Infraschall ebenfalls zu diesen Beschwerden führen könnte. Er sieht darin eine Erklärung für die Tatsache, dass manche Anwohner von WEA die Symptome aufweisen, andere jedoch nicht. Ähnlich sei es bei der Seekrankheit, deren Symptome denen des „Wind Turbine Syndrome“ auffallend ähneln: Auch hier gibt es eine Suszeptibilität bei nur 5 bis 10 % der Bevölkerung, die mit starken Symptomen reagieren (12).“

Überblick über einschlägige Studien durch Loren Knopper

Knopper und Ollson untersuchen die Vielzahl der existierenden Studien zu eventuellen gesundheitlichen Schäden durch Windräder und fassen ihre Untersuchungsergebnisse zusammen (158):

„[…] in „peer reviewed (begutachteten)“ Studien existiert ein statistischer Zusammenhang der Belästigung durch Windräder mit dem Windradlärm, aber der Zusammenhang ist noch stärker durch den visuellen Eindruck , der Einstellung zu Windrädern und der allgemeinen Lärmempfindlichkeit bedingt. Bis heute beweist kein „peer rewiewter“ Artikel einen direkten kausalen Zusammenhang zwischen gesundheitlichen Problemen von Personen in der Nähe von modernen Windrädern und dem von diesen erzeugten Lärm . Wenn überhaupt können selbst-dokumentierte Gesundheitsproblem, wahrscheinlich verschiedenen Umweltstressoren zugeschrieben werden, die bei einem Teil der Bevölkerung einen Zustand von Belästigung und Stress erzeugen. In der populärwissenschaftlichen Literatur hängen selbst-dokumentierte Gesundheitsprobleme von der Entfernung von den Turbinen ab und es wird behauptet, dass der Infraschall der ursächliche Parameter für die berichteten Problem sei, auch wenn der Schalldruck nicht genmessen wurde.“

Am Ende steht unter „Konkurrierende Interessen“

„In Bezug auf konkurrierende Interessen, finanziell und nicht finanziell, arbeiten die Autoren für eine Consulting-Firma und haben mit Windenergiefirmen zusammengearbeitet.“

2.3.2.8 Windkraft: Der Nocebo-Effekt und die Tierwelt.

Unter dem Titel Macht der Infraschall von Windkraftanlagen krank?

untersucht Daniel Wetzel die Diskussion der schädlichen Wirkung der Windkraft in Dänemark. (159)

In Wikipedia findet man zur Bedeutung Dänemarks für die Entwicklung der Windkraft:

„Dänemark war u. a. aufgrund seiner durch die geographische Lage des Landes bedingten guten Windbedingungen sowie der Tradition der Windenergienutzung, auf die in den 1970er Jahren institutionell wie technologisch aufgebaut werden konnte, der Pionier in der Entwicklung der modernen Windkrafttechnik (siehe auch Geschichte der Windenergienutzung). Von Dänemark aus verbreitete sich die Windenergienutzung ab den 1970er Jahren weltweit.“

Daniel Wetzel schreibt:

„Wie nahe dürfen Windkraftanlagen an bewohnte Ortschaften heranrücken? Berichte über gesundheitsschädliche Schallemissionen von Windkraftanlagen haben in Dänemark schon zu einer dramatischen Verlangsamung des Ausbautempos geführt

Aus Angst vor Gesundheitsschäden durch Infraschall werden in Dänemark kaum noch Windenergie-Anlagen gebaut. Eine staatliche Untersuchung läuft. Deutsche Behörden spielen das Problem noch herunter.

Beim ersten Test begannen die Tiere zu schreien. „Sie tobten mit einem schrillen Kreischen in ihren Käfigen und begannen sich gegenseitig zu beißen“, sagt Kaj Bank Olesen, Nerzzüchter in Vildbjerg, Dänemark.

Als seine Tierärztin im Morgengrauen die Polizei in der Gemeinde Herning anrief, um die neuen Windkraftanlagen hinter Olesens Bauernhof abschalten zu lassen, lag schon ein halbes Dutzend Tiere tot in den Käfigen. Mehr als 100 hatten sich gegenseitig so tiefe Wunden zugefügt, dass sie getötet werden mussten. […]

Plötzlich ist Flaute im Staate Dänemark

Das Schicksal des jütländischen Nerzzüchters machte landesweit Schlagzeilen und beschäftigte sogar das Parlament in Kopenhagen. Und seitdem hat die Energiewende ein Problem, wie Jan Hylleberg eingesteht, der Vorstandschef des Verbandes der dänischen Windindustrie: „Ein Großteil der dänischen Kommunen hat die Pläne für neue Windparks auf Eis gelegt, bis die staatliche Untersuchung über die Gesundheitsprobleme durch Infraschall abgeschlossen ist.“[…]

Das kleine Nachbarland ist mit einem Anteil von 40 Prozent am Stromverbrauch weltweit führend bei der Windstromerzeugung. […]

In dem 5,6-Millionen-Einwohner-Staat sind allerdings inzwischen mehr als 200 Bürgerinitiativen gegen Windparks aktiv. Und das liegt nicht nur an den europaweit höchsten Strompreisen. […]

Staudengärtner Boye Jensen (67) musste seinen Betrieb aufgeben. Seine Arbeiterinnen klagten über gravierende gesundheitliche Probleme, seitdem unmittelbar neben dem Betrieb Windkraftanlagen errichtet wurden

Zwei Wochen später litt Jensen nach eigener Aussage an Schlaflosigkeit. Nachts fühlte er ein „Vibrieren im Brustkorb“, sagt er. „Ich war schon direkt nach dem Aufstehen erschöpft.“ Doch Jensens eigentlicher Albtraum begann erst einige Monate später, als ihm mehrere seiner Gärtnerinnen sagten, dass sie unter Kopfschmerzen und Menstruationsproblemen litten. […]

Das World Council for Nature, eine internationale Organisation, die Windkraft aus Naturschutzgründen ablehnt, warf der dänischen Regierung in einem offenen Brief vor, die wachsende Zahl der Belege für die Existenz eines „Windturbinen-Syndroms“ zu ignorieren.

All das löste in Jensens Staudengärtnerei Panik aus. Fünf Angestellte kündigten ihren Job fristlos. Doch die Banken akzeptierten den Plan nicht und kündigen die Kreditlinien. Jensen musste Insolvenz anmelden. […]

Weil die Zahl der Anti-Windkraft-Gruppen rasch zunahm, gab die Regierung Ende 2013 eine Studie über mögliche Gesundheitsgefahren von Windkraftanlagen in Auftrag. […]

Der Windkraftgegner als eingebildeter Kranker: Auch deutsche Behörden neigen zu dieser Sichtweise, weil die Beweise für die Existenz von Windkraft-Krankheiten bislang dünn waren. […]

Fazit der baden-württembergischen Behörden: „Ein Windturbinen-Syndrom gibt es nicht.“

Auch die Bayerischen Landesämter für Umwelt, Gesundheit und Lebensmittelsicherheit erklären die Unbedenklichkeit von tieffrequentem Schall: „Die von Windenergieanlagen erzeugten Infraschallpegel in üblichen Abständen zur Wohnbebauung liegen deutlich unterhalb der Hör- und Wahrnehmungsgrenzen“, heißt es dort. […]

Was man nicht hört, kann nach Einschätzung der Beamten auch nicht schädlich sein. […]

Auch Untersuchungen der Ludwig-Maximilians-Universität München widersprechen den bayerischen Aufsichtsämtern: „Die Annahme, tiefe Töne würden vom Ohr nicht verarbeitet, weil sie nicht oder schwer hörbar sind, ist falsch“, sagt der Neurobiologe Markus Drexl: „Das Ohr reagiert sehr wohl auch auf sehr tieffrequente Töne.“ […]

Emissionen von Windkraftanlagen werden nach der „Technischen Anleitung zum Schutz gegen Lärm“ (TA Lärm) gemessen. Nach dieser Vorschrift findet die Messung aber stets nur im Freien statt. Ungenügend, finden Akustiker: Denn Innenräume verstärken die Wirkung von tiefen Frequenzen oft noch. Baukörper schirmen gerade gegen Schwingungen unterhalb von 100 Hertz schlecht ab, durch große Fenster können sie fast ungehindert eindringen.

Frustrierende Erfahrungen

Weiterer Nachteil der TA Lärm: Sie schreibt vor, dass der Schalldruckpegel auf eine Art gemessen werden muss, mit der das Lautstärkeempfinden des menschlichen Ohres nachbildet wird. Nur: Diese sogenannte A-Bewertung, gemessen in Dezibel-A, gewichtet höhere Tonlagen aus Prinzip stärker, da zum Beispiel schrille Geräusche von Menschen gemeinhin auch als größere Belästigung wahrgenommen werden.

Die speziell tiefen Frequenzen, die von Windkraftanlagen ausgehen, werden bei dieser Art der Messung aber ignoriert.

Zwar bestimmt die TA Lärm auch, dass bei Hinweisen auf tiefe Frequenzen weitere Messungen zu erfolgen haben. Nur: Diese weiteren Messungen sollen dann nach den Vorgaben einer Deutschen Industrienorm durchgeführt werden. Und diese DIN 45680 hat, wie jede DIN, nicht mehr den Charakter einer Rechtsvorschrift, sondern schlicht den einer Empfehlung. […]

Die Dänen haben aus dem Dilemma einen Ausweg gefunden. An Land werden zwar nur noch wenige neue Anlagen hinzukommen, glaubt Jan Hylleberg, der Chef des Windindustrie-Verbandes. Das Wachstum werde aber auf dem Meer erfolgen.

Mit zwei neuen Großwindparks in Nord- und Ostsee soll die 50-Prozent-Marke beim Ökostromanteil bis 2020 übersprungen werden. In dänischen Küstengewässern gebe es dann ebenso viel Windkraftleistung wie an Land.

Deutschland will diesem Öko-Vorbild nicht folgen. Im Gegenteil: Die Ausbaupläne für Offshore-Wind wurden jüngst kräftig zusammengestaucht. Die Bundesregierung will bis 2020 nur noch 6500 Megawatt in Nord- und Ostsee zulassen, während es an Land bereits mehr als 35.000 Megawatt Windkraft gibt.

Dänemark verringert die Onshore-Windkraft

Im Jahre 2018 beschliesst das dänische Parlament einstimmig im Rahmen der Energiepolitik bis 2030, die zu diesem Zeitpunkt existierenden 4300 onshore-Windräder in Zukunft auf 1850 zu begrenzen (160)

In der Zwischenzeit hat die dänische Regierung die Entscheidung aufgeschoben, da die Vertretung der dänischen Windwirtschaft „Wind Denmark“ die geschätzte Lebenszeit von Windrädern von etwa 25 Jahren auf etwa 35 Jahre angehoben hat, so dass die Realisierung der Windradreduktion den dänischen Steuerzahler 6.6 Billionen DK (etwa 900 Milliarden Euro) kosten würde. Dänemark hat mit Deutschland die teuersten Strompreise in Europa (161).

2.3.2.9 Der Konflikt wissenschaftlicher Arbeit und wirtschaftlicher Interessen

Curt Devlin, ehemaliger Lehrbeauftragter für Philosophie an der Tulane Universität, New Orleans, entwickelt heute Software für die Entdeckung und Behandlung von Krebsleiden.

Er beklagt, dass die Windenergieindustrie mit millionenschweren Studien, die Ungefährlichkeit der Windräder demonstrieren will (162). Er führt als Beispiel der „Täuschung der Öffentlichkeit“ die “Wind Turbine Health Impact Study: Report of Independent Expert Panel” (s. unten) an, die im Jahre 2012 durch „das unheilige Bündnis von Windindustrie und dem Büro des Gouverneurs von Massachusetts entstanden ist“.

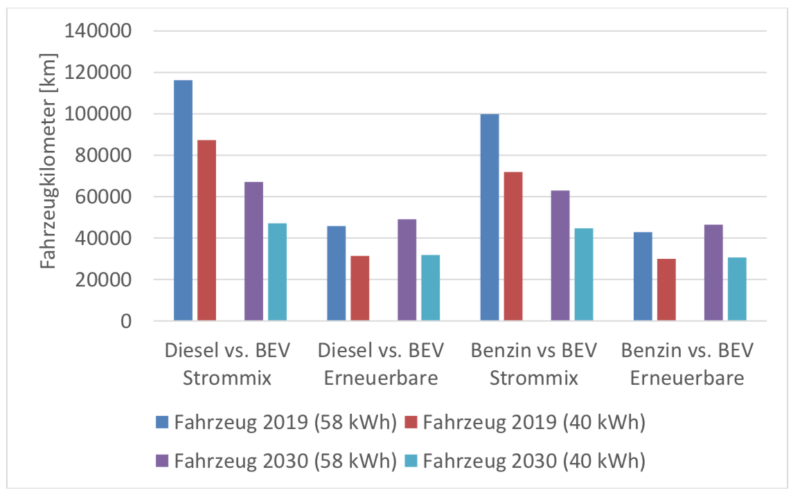

„Dies (Autor: bewusste Missachtung der Leiden der Anwohner) ist der Grund warum die Wind-Industrie strategisch und systematisch versucht hat Turbinenbetreiber und Anwohner mit Landaufkäufen und Geheimhaltungsvereinbarungen ruhig zu stellen. Zweifelsfrei ist dies auch der Grund warum sie und ihre Unterstützer diejenigen Akustik- Ingenieure, Ärzte und behördliche Gesundheitsexperten öffentlich angegriffen haben, die, in Übereinstimmung mit ihrem Berufsethos, versucht haben, die Wahrheit öffentlich bekannt zu machen. Diese Industrie macht seriöse Wissenschaft lächerlich, und stellt seine Vertreter als Verleumder und seine schlaflosen Opfer als geisteskrank hin. Dies alles um bewusste kriminelle Grausamkeit zu bemänteln, die im Namen ungezügelter Gier begangen wird.